Theo dõi đối tượng trực quan từ dữ liệu video sử dụng học trực tuyến

TÓM TẮT

Theo dõi đối tượng trực quan từ dữ liệu video là một vấn đề rất được quan tâm

trong lĩnh vực thị giác máy tính. Trong bài báo này có 2 đóng góp chính:

(1) Sử dụng thêm một thuật toán học đối tượng trực quan đáng tin cậy cho quá

trình theo dõi; (2) Đề xuất một chiến lược hiệu quả cho việc khôi phục các vị trí đối

tượng theo dõi bị thất lạc hoặc bị sai vị trí phát hiện trở lại đúng vị trí đối tượng

xuất hiện. Ý tưởng của tôi là kết hợp việc ra quyết định của bộ phát hiện được

huấn luyện trước một cách chắc chắn với một bộ theo dõi trực tuyến. Điều này cho

phép tránh được sự thất lạc và mất dấu vết trong quá trình theo dõi đối tượng.

Trong các thực nghiệm dựa trên các bộ dữ liệu chuẩn cho một số ứng dụng cho

thấy hiệu năng cao bao gồm độ chính xác cao, tốc độ trực tuyến và tính hữu hiệu

của của phương pháp đề xuất.

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Tóm tắt nội dung tài liệu: Theo dõi đối tượng trực quan từ dữ liệu video sử dụng học trực tuyến

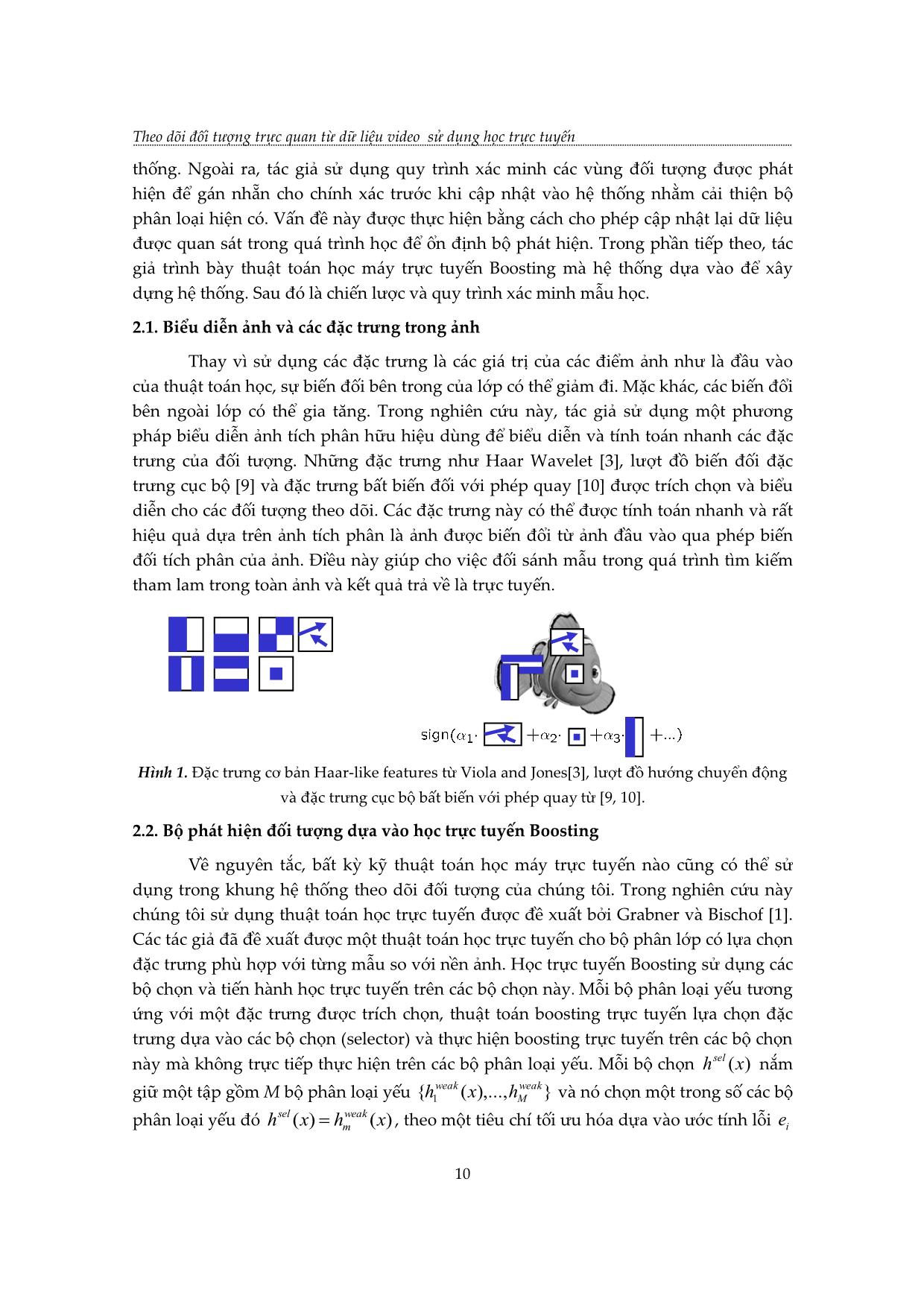

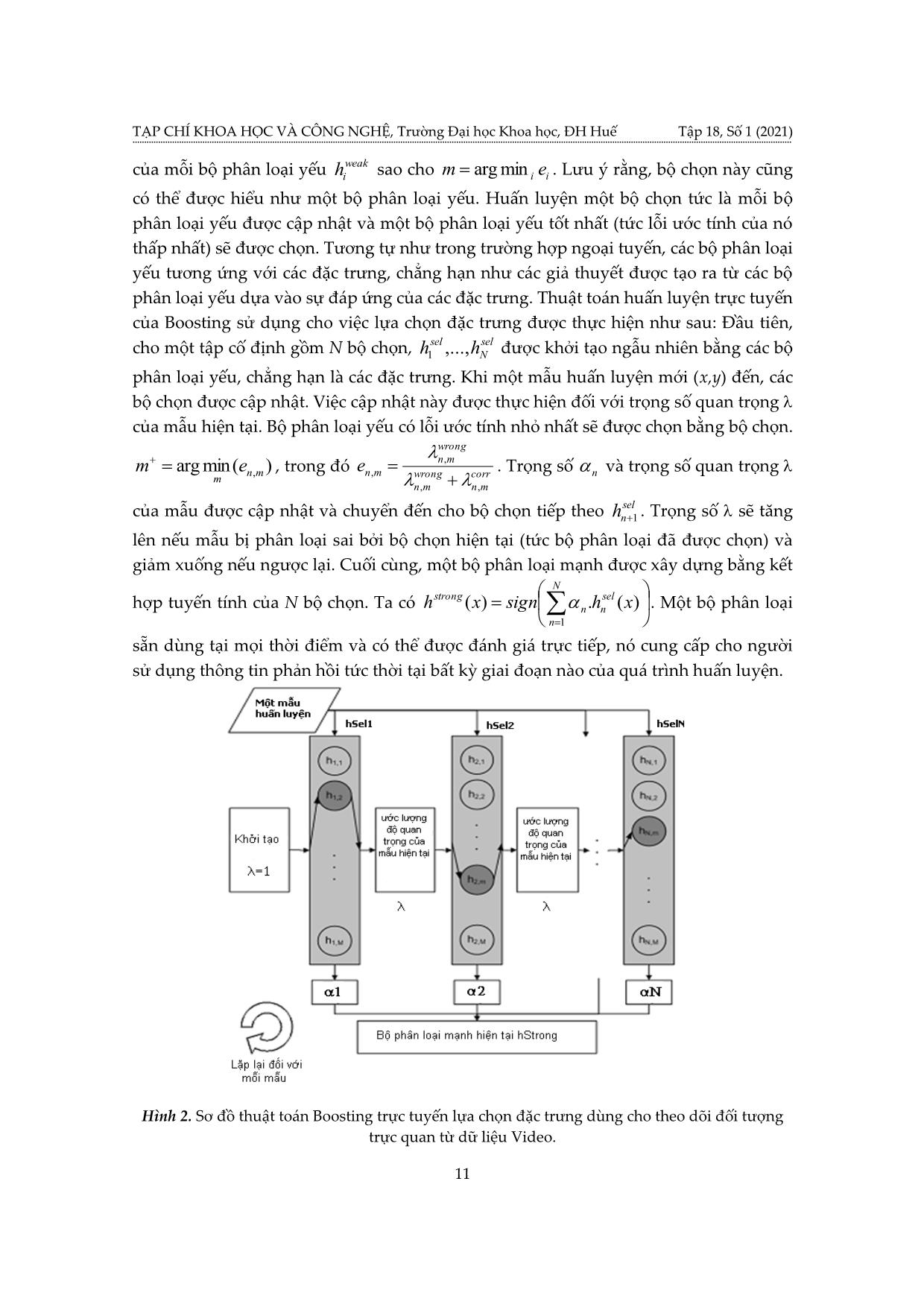

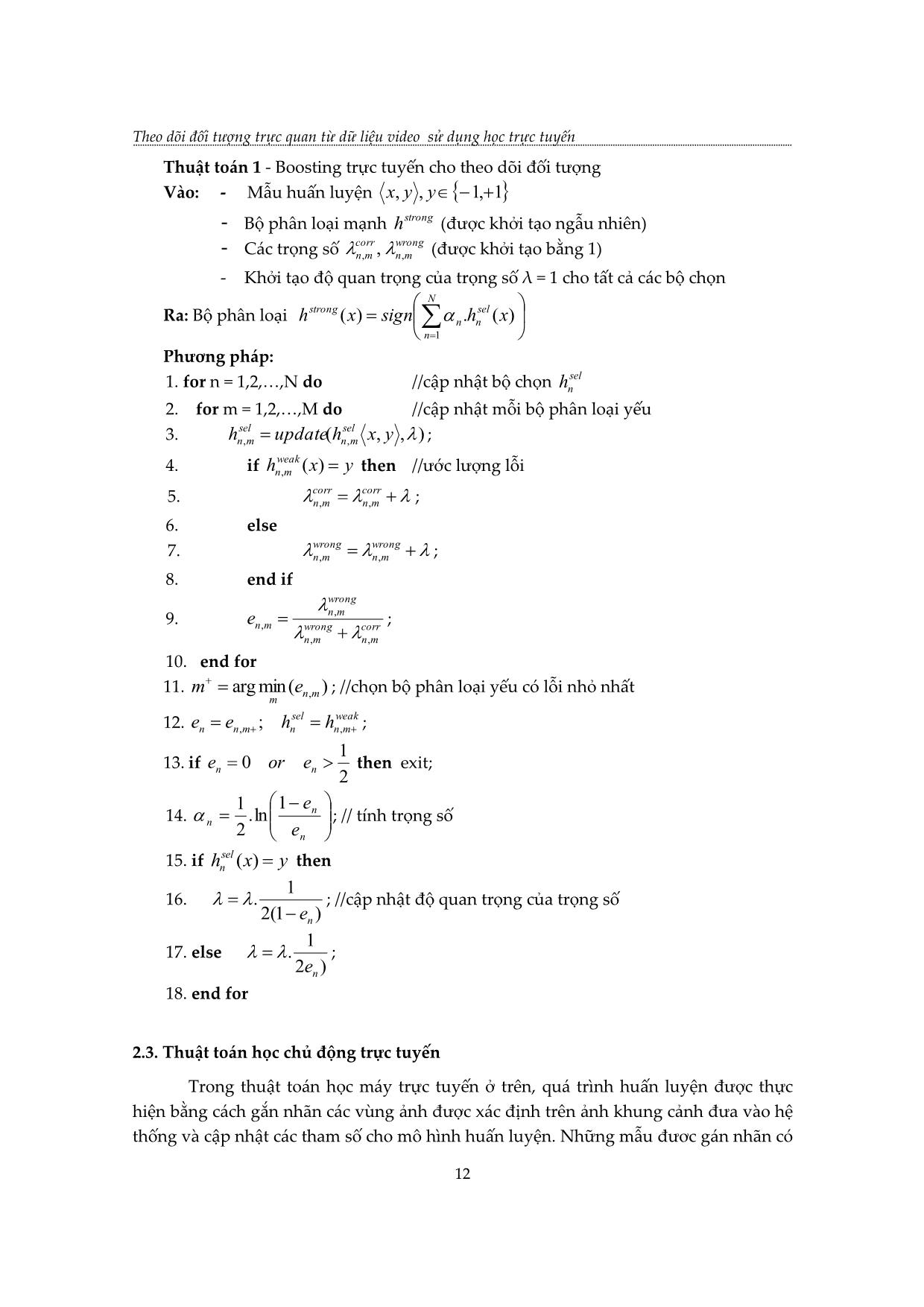

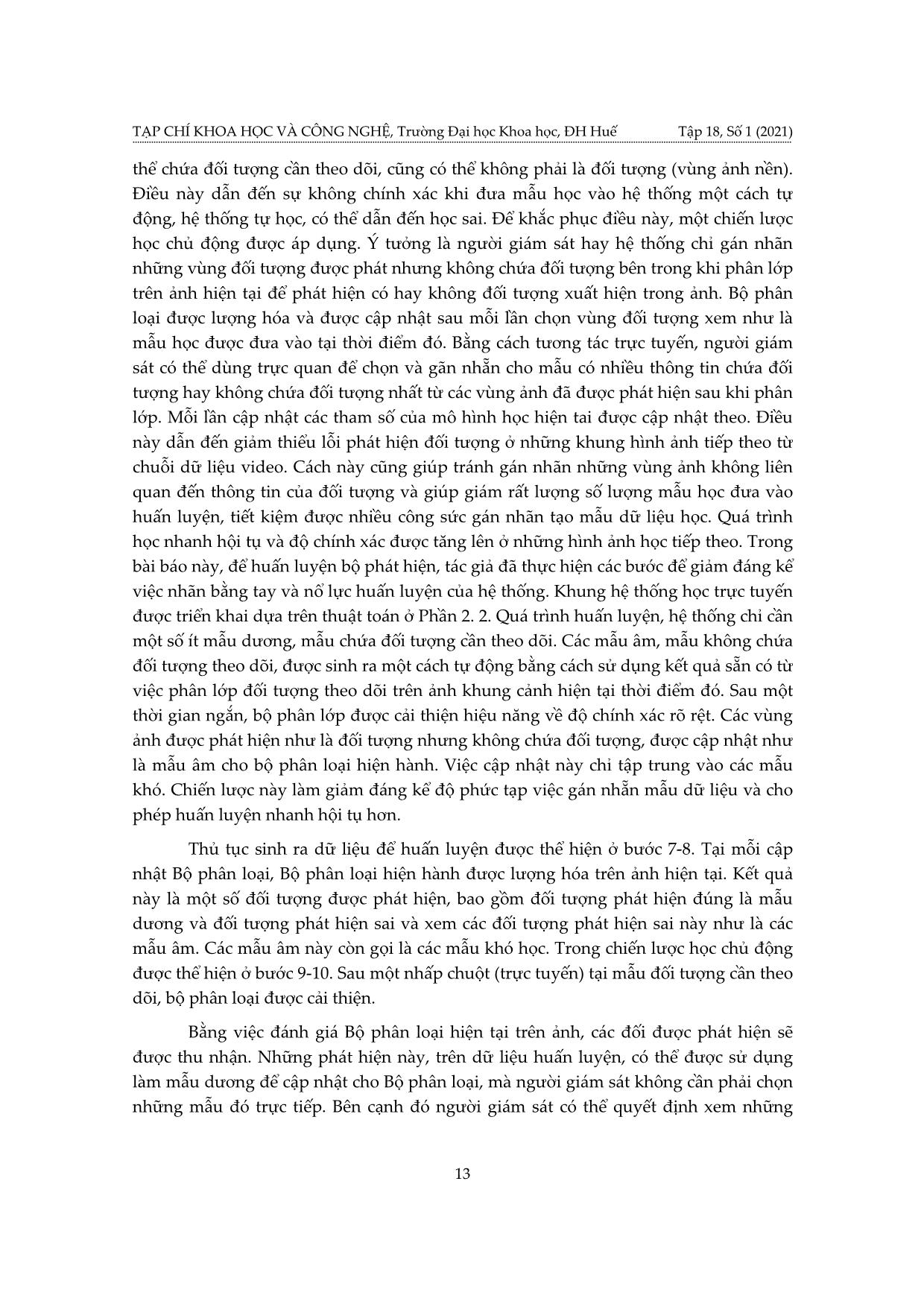

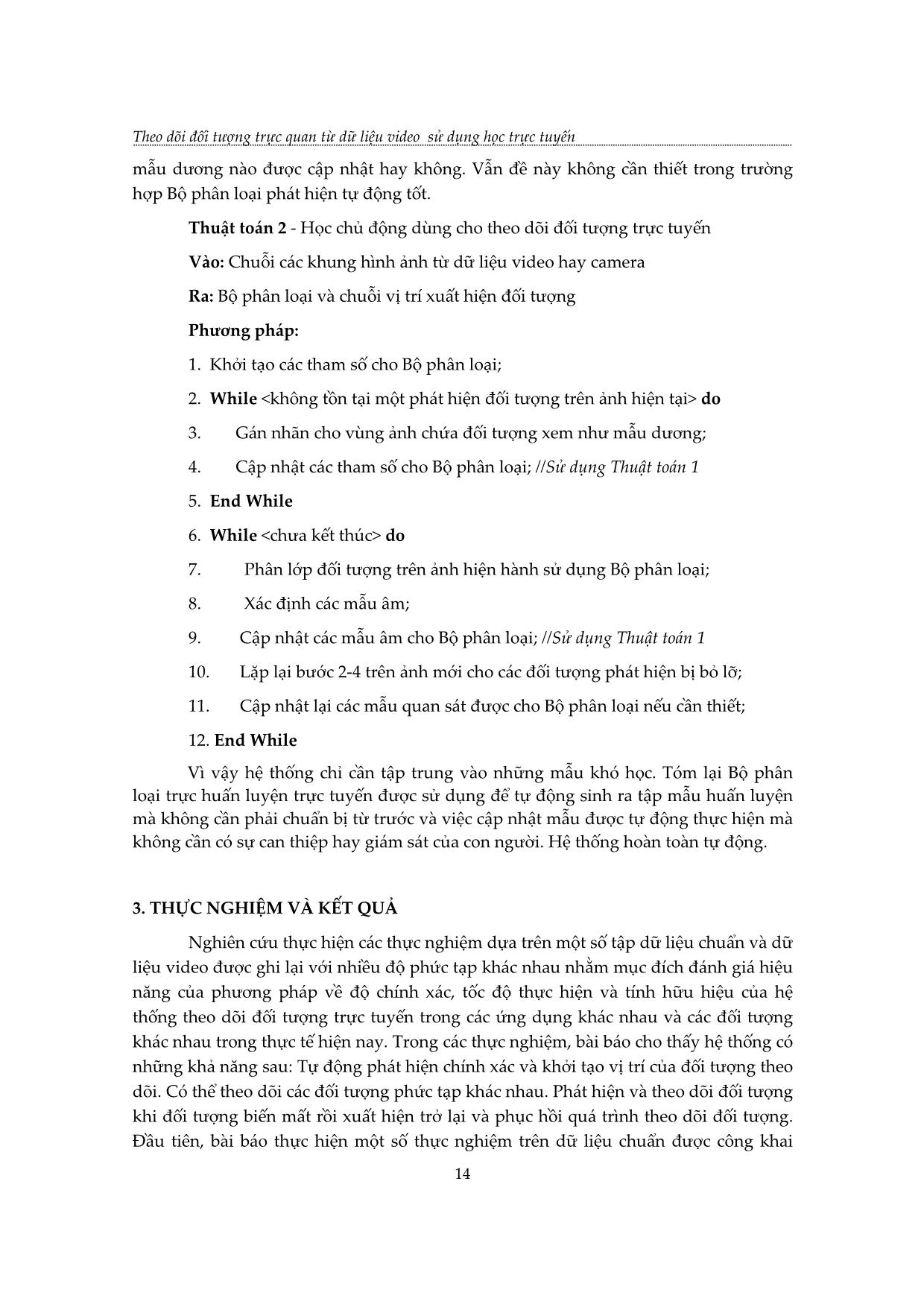

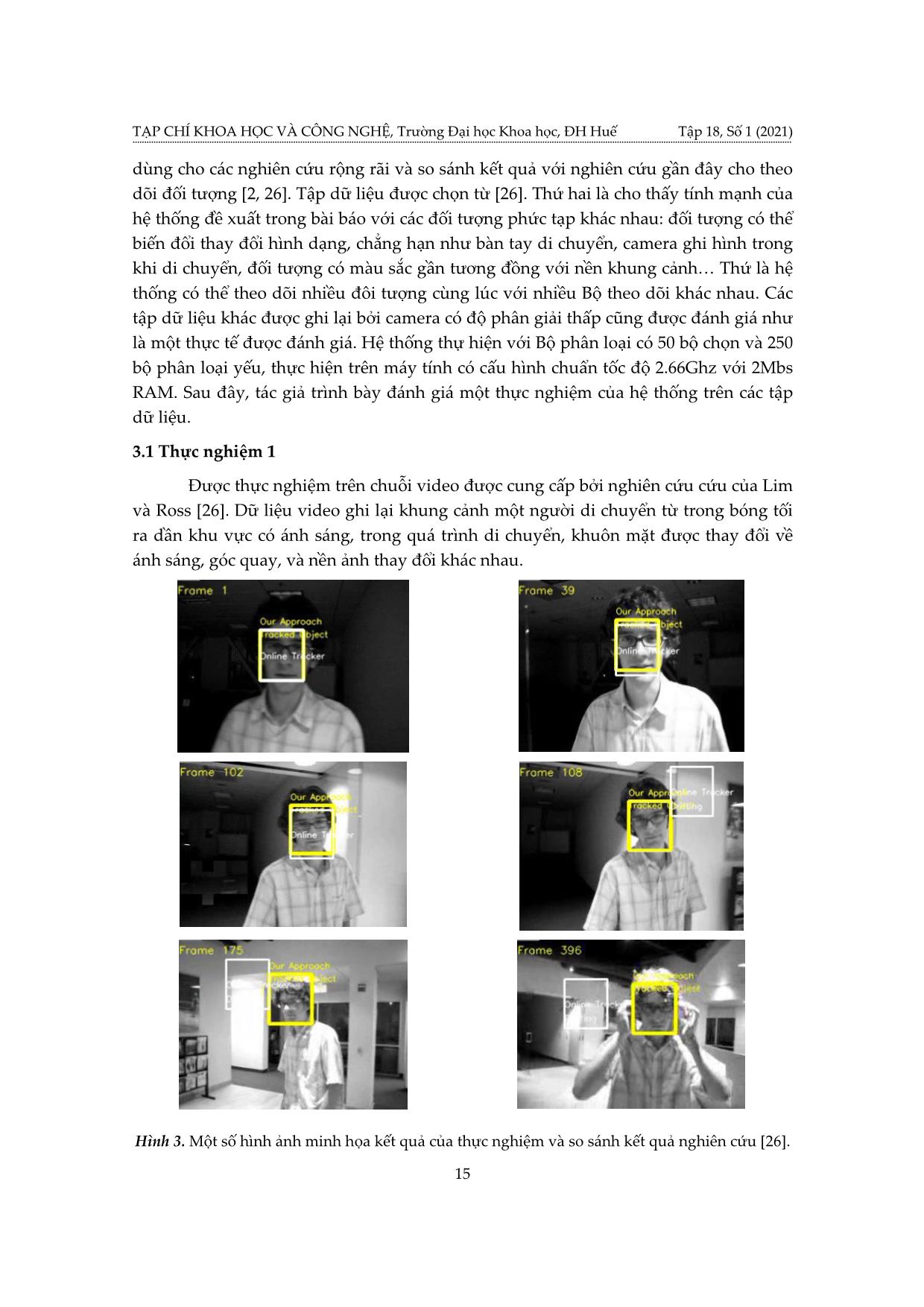

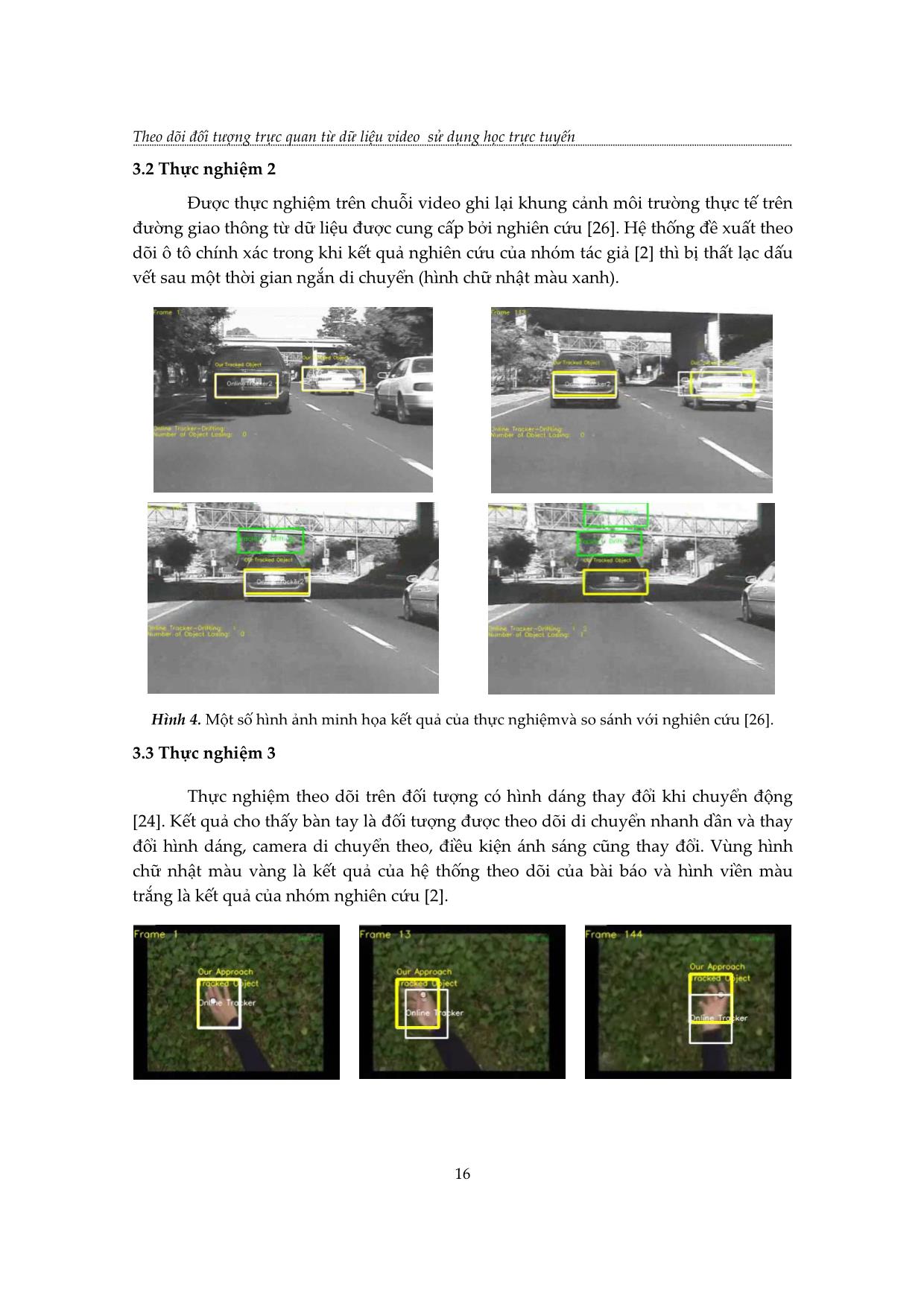

ện ở bước 9-10. Sau một nhấp chuột (trực tuyến) tại mẫu đối tượng cần theo dõi, bộ phân loại được cải thiện. Bằng việc đánh giá Bộ phân loại hiện tại trên ảnh, các đối được phát hiện sẽ được thu nhận. Những phát hiện này, trên dữ liệu huấn luyện, có thể được sử dụng làm mẫu dương để cập nhật cho Bộ phân loại, mà người giám sát không cần phải chọn những mẫu đó trực tiếp. Bên cạnh đó người giám sát có thể quyết định xem những Theo dõi đối tượng trực quan từ dữ liệu video sử dụng học trực tuyến 14 mẫu dương nào được cập nhật hay không. Vẫn đề này không cần thiết trong trường hợp Bộ phân loại phát hiện tự động tốt. Thuật toán 2 - Học chủ động dùng cho theo dõi đối tượng trực tuyến Vào: Chuỗi các khung hình ảnh từ dữ liệu video hay camera Ra: Bộ phân loại và chuỗi vị trí xuất hiện đối tượng Phương pháp: 1. Khởi tạo các tham số cho Bộ phân loại; 2. While do 3. Gán nhãn cho vùng ảnh chứa đối tượng xem như mẫu dương; 4. Cập nhật các tham số cho Bộ phân loại; //Sử dụng Thuật toán 1 5. End While 6. While do 7. Phân lớp đối tượng trên ảnh hiện hành sử dụng Bộ phân loại; 8. Xác định các mẫu âm; 9. Cập nhật các mẫu âm cho Bộ phân loại; //Sử dụng Thuật toán 1 10. Lặp lại bước 2-4 trên ảnh mới cho các đối tượng phát hiện bị bỏ lỡ; 11. Cập nhật lại các mẫu quan sát được cho Bộ phân loại nếu cần thiết; 12. End While Vì vậy hệ thống chỉ cần tập trung vào những mẫu khó học. Tóm lại Bộ phân loại trực huấn luyện trực tuyến được sử dụng để tự động sinh ra tập mẫu huấn luyện mà không cần phải chuẩn bị từ trước và việc cập nhật mẫu được tự động thực hiện mà không cần có sự can thiệp hay giám sát của con người. Hệ thống hoàn toàn tự động. 3. THỰC NGHIỆM VÀ KẾT QUẢ Nghiên cứu thực hiện các thực nghiệm dựa trên một số tập dữ liệu chuẩn và dữ liệu video được ghi lại với nhiều độ phức tạp khác nhau nhằm mục đích đánh giá hiệu năng của phương pháp về độ chính xác, tốc độ thực hiện và tính hữu hiệu của hệ thống theo dõi đối tượng trực tuyến trong các ứng dụng khác nhau và các đối tượng khác nhau trong thực tế hiện nay. Trong các thực nghiệm, bài báo cho thấy hệ thống có những khả năng sau: Tự động phát hiện chính xác và khởi tạo vị trí của đối tượng theo dõi. Có thể theo dõi các đối tượng phức tạp khác nhau. Phát hiện và theo dõi đối tượng khi đối tượng biến mất rồi xuất hiện trở lại và phục hồi quá trình theo dõi đối tượng. Đầu tiên, bài báo thực hiện một số thực nghiệm trên dữ liệu chuẩn được công khai TẠP CHÍ KHOA HỌC VÀ CÔNG NGHỆ, Trường Đại học Khoa học, ĐH Huế Tập 18, Số 1 (2021) 15 dùng cho các nghiên cứu rộng rãi và so sánh kết quả với nghiên cứu gần đây cho theo dõi đối tượng [2, 26]. Tập dữ liệu được chọn từ [26]. Thứ hai là cho thấy tính mạnh của hệ thống đề xuất trong bài báo với các đối tượng phức tạp khác nhau: đối tượng có thể biến đổi thay đổi hình dạng, chẳng hạn như bàn tay di chuyển, camera ghi hình trong khi di chuyển, đối tượng có màu sắc gần tương đồng với nền khung cảnh Thứ là hệ thống có thể theo dõi nhiều đôi tượng cùng lúc với nhiều Bộ theo dõi khác nhau. Các tập dữ liệu khác được ghi lại bởi camera có độ phân giải thấp cũng được đánh giá như là một thực tế được đánh giá. Hệ thống thự hiện với Bộ phân loại có 50 bộ chọn và 250 bộ phân loại yếu, thực hiện trên máy tính có cấu hình chuẩn tốc độ 2.66Ghz với 2Mbs RAM. Sau đây, tác giả trình bày đánh giá một thực nghiệm của hệ thống trên các tập dữ liệu. 3.1 Thực nghiệm 1 Được thực nghiệm trên chuỗi video được cung cấp bởi nghiên cứu cứu của Lim và Ross [26]. Dữ liệu video ghi lại khung cảnh một người di chuyển từ trong bóng tối ra dần khu vực có ánh sáng, trong quá trình di chuyển, khuôn mặt được thay đổi về ánh sáng, góc quay, và nền ảnh thay đổi khác nhau. Hình 3. Một số hình ảnh minh họa kết quả của thực nghiệm và so sánh kết quả nghiên cứu [26]. Theo dõi đối tượng trực quan từ dữ liệu video sử dụng học trực tuyến 16 3.2 Thực nghiệm 2 Được thực nghiệm trên chuỗi video ghi lại khung cảnh môi trường thực tế trên đường giao thông từ dữ liệu được cung cấp bởi nghiên cứu [26]. Hệ thống đề xuất theo dõi ô tô chính xác trong khi kết quả nghiên cứu của nhóm tác giả [2] thì bị thất lạc dấu vết sau một thời gian ngắn di chuyển (hình chữ nhật màu xanh). Hình 4. Một số hình ảnh minh họa kết quả của thực nghiệmvà so sánh với nghiên cứu [26]. 3.3 Thực nghiệm 3 Thực nghiệm theo dõi trên đối tượng có hình dáng thay đổi khi chuyển động [24]. Kết quả cho thấy bàn tay là đối tượng được theo dõi di chuyển nhanh dần và thay đổi hình dáng, camera di chuyển theo, điều kiện ánh sáng cũng thay đổi. Vùng hình chữ nhật màu vàng là kết quả của hệ thống theo dõi của bài báo và hình viền màu trắng là kết quả của nhóm nghiên cứu [2]. TẠP CHÍ KHOA HỌC VÀ CÔNG NGHỆ, Trường Đại học Khoa học, ĐH Huế Tập 18, Số 1 (2021) 17 Hình 4. Một số hình ảnh minh họa kết quả của thực nghiệm thực tế và so sánh với kết quả nghiên cứu [2]. 4. KẾT LUẬN VÀ HƯỚNG PHÁT TRIỂN Bài báo đã trình bày một phương pháp theo dõi đối tượng trực tuyến kết hợp giữa một bộ phát hiện đối tượng mạnh và một Bộ theo dõi thích nghi trực tuyến. Hệ thống được xây dựng và cài đặt có thể phát triển cho các ứng dụng thực tế với các đối tượng khác nhau trong các ứng dụng thực tế. Các kết quả thực nghiệm đã cho thấy hệ thống thu được hiệu năng tốt về các độ chính xác và tốc độ trực tuyến, có thể cài đặt chạy trên hệ thống máy tính cấu hình thấp đến cấu hình mạnh. Hệ thống tự động phát hiện tự động đối tượng và khởi tạo quá trình theo dõi một cách tự động và có thể phát hiện đối tượng biến mất trong quá trình theo dõi, có thể khôi phục tiếp việc theo dõi khi đối tượng xuất hiện trở lại trong chuỗi dữ liệu video. Các kết quả được thực nghiệm trong các dữ liệu video môi trường thực với các độ phức tạp khác nhau và cho thấy có tiềm năng phát triển các ứng dụng thực tế cả trong môi trường trong nhà và ngoài trời. Trong hướng phát triển, tác giả có kế hoạch mở rộng nghiên cứu này cho hệ thống giám sát thông minh. Với nhiều loại dữ liệu phức tạp hơn và môi trường phức tạp trong thực tế. TÀI LIỆU THAM KHẢO [1] H. Grabner and H. Bischof. On-line boosting and vision. In Proceedings IEEE Conference Computer Vision and Pattern Recognition, Vol. 1, pp. 260–267, 2006. [2] H. Grabner, M. Grabner, H. Bischof. Real-time tracking via on-line boosting. In: Proc. BMVC. Vol. 1, pp. 47–56, 2006 Theo dõi đối tượng trực quan từ dữ liệu video sử dụng học trực tuyến 18 [3] P. Viola and M. Jones. Rapid object detection using a boosted cascade of simple features. In Proceedings IEEE Conference Computer Vision and Pattern Recognition, volume I, pp. 511– 518, 2001. [4] K. Okuma, A. Taleghani, D. Freitas, J. J. Little, and D. G. Lowe. A boosted particle filter: Multitarget detection and tracking. In ECCV, 2004. [5] O. Javed, S. Ali, and M. Shah. Online detection and classification of moving objects using progressively improving detectors. In Proceedings CVPR, pp. 695–700, San Diego, CA, USA, 2005. [6] B. Lucas and T. Kanade, An iterative image registration technique with an application to stereo vision. In Proceedings of International Joint Conference on Artificial Intelligence, pp. 674–679, 1981. [7] M. Han, A. Sethi, W. Hua, and Y. Gong. A detection based multiple object tracking method. In ICIP, 2004. [8] R. Kaucic, A. G. A. Perera, G. Brooksby, J. Kaufhold, and A. Hoogs. A unified framework for tracking through occlusions and across sensor gaps. In CVPR, 2005. [9] N. Dalal and B. Triggs. Histograms of oriented gradients for human detection. In Proceedings, CVPR, volume 1, pp. 886–893, San Diego, CA, USA, 2005. [10] T. Ojala, M. Pietikainen, and T. Maenpaa, Multiresolution gray-scale and rotation invariant texture classification with local binary patterns. Pattern Analysis and Machine Intelligence, 24(7), pp. 971–987, 2002. [11] S. Avidan, Support vector tracking. IEEE Trans. PAMI 26, pp. 1064–1072, 2004 [12] V. Lepetit, P. Lagger, P. Fua. Randomized trees for real-time keypoint recognition. In: Proc. CVPR. Volume 2., pp. 775–781, 2005 [13] M. Ozuysal, P. Fua, , V. Lepetit, Fast keypoint recognition in ten lines of code. In: CVPR. (2007) [14] R. Collins, Y. Liu, M. Leordeanu, Online selection of discriminative tracking features. IEEE Trans. PAMI 27, pp. 1631–1643, 2005 [15] B. Han and L. Davis, On-line density-based appearance modeling for object tracking, in Proc. ICCV, volume 2, pp. 1492–1499, 2005. [16] S. Avidan. Emsemble tracking. In proc. CVPR, Vol. 2, pp. 494-501, 2005 [17] I. Matthews, T. Ishikawa, S. Baker, The template update problem. IEEE Trans. PAMI 26 , pp. 810 – 815, 2004 [18] M. Grabner, H. Grabner, H. Bischof, Learning features for tracking. In: Proc. CVPR. 2007 [19] F. Tang, S. Brennan, Q. Zhao, H. Tao, Co-tracking using semi-supervised support vector machines, in Proc. ICCV, pp. 1–8, 2007 [20] T. Woodley, B. Stenger, R. Cipolla, Tracking using online feature selection and a local generative model. In: Proc. BMVC, 2007 TẠP CHÍ KHOA HỌC VÀ CÔNG NGHỆ, Trường Đại học Khoa học, ĐH Huế Tập 18, Số 1 (2021) 19 [21] Y. Li, H. Ai, T. Yamashita, S. Lao,M. Kawade, Tracking in low frame rate video: A cascade particle filter with discriminative observers of different lifespans. In: Proc. CVPR., pp. 1–8, 2007 [22] A. D. Jepson, D. J. Fleet, and T.F. El-Maraghi. Robust online appearance models for visual tracking. In Proc. CVPR, volume 1, pp. 415–422, 2001. [23] J. Lim, D. Ross, R. Lin and M.Yang, Incremental learning for visual tracking, In Advances in Neural Information Processing System 17, pp. 793-800, MIT Press, 2005 [24] M.Kolsch and M. Turk, “Fast 2D Hand Tracking with Flocks of Features and Multi-Cue Intergration, ” IEEE Computer Society Conference on Computer Vision and Pattern Recognition Workshop, pp. 158-166, 2004. [25] J.Wang, X. Chen, and W. Gao, Online selecting discriminative tracking features using particle filter, in Proc. CVPR, volume 2, pp. 1037–1042, 2005. [26] D. Ross, J. Lim, R. Lin, M.H. Yang, Incremental Learning for Robust Visual Tracking, the International Journal of Computer Vision, Special Issue: Learning for Vision, 2007. [27] M. J. Black and A. D. Jepson, Eigentracking: Robust matching and tracking of articulated objects using view based representation. In B. Buxton and R. Cipolla, editors, Proceedings of the Fourth European Conference on Computer Vision, LNCS 1064, pp. 329–342. Springer Verlag, 1996. [28] M. J. Black, D. J. Fleet, and Y. Yacoob, A framework for modeling appearance change in image sequence. In Proceedings of IEEE International Conference on Computer Vision, pp. 660–667, 1998. [29] M. Isard and A. Blake. Contour tracking by stochastic propagation of conditional density. In B. Buxton and R. Cipolla, editors, Proceedings of the Fourth European Conference on Computer Vision, LNCS 1064, pp. 343–356. Springer Verlag, 1996. [30] O. Williams, A. Blake, and R. Cipolla, A sparse probabilistic learning algorithms for real- time tracking. In Proceedings of IEEE International Conference on Computer Vision, volume 1, pp. 353–360, 2003. [31] M. Harville, A framework for high-level feedback to adaptive, per-pixel mixture of Gaussian background models. In A. Heyden, G. Sparr, M. Nielsen, and P. Johansen, editors, Proceedings of the Seventh European Conference on Computer Vision, LNCS 2352, pages 531–542. Springer Verlag, 2002. [32] G. Hager and P. Belhumeur, Real-time tracking of image regions with changes in geometry and illumination. In Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, pages 403–410, 1996. [33] D. Comaniciu, V. Ramesh, and P. Meer, Real-time tracking of non-rigid objects using mean shift. In Proc. CVPR, volume 2, pp. 142–149, 2000. [34] J. Ho, K. Lee, M. Yang, and D. Kriegman. Visual tracking using learned linear subspaces. In Proc. CVPR, volume 1, pp. 782–789, 2004. [35] D. Ross, J. Lim, and M. Yang. Adaptive proballistic visual tracking with incremental subspace update. In Proc. ECCV, volume 2, pp. 470–482, 2004. Theo dõi đối tượng trực quan từ dữ liệu video sử dụng học trực tuyến 20 [36] J. Vermaak, P. Perez, M. Gangnet, and A. Blake. Towards improved observation models for visual tracking: Selective adaption. In Proc. ECCV, pp. 645–660, 2002. [37] D. Comaniciu, V. Ramesh, and P. Meer. Kernel-based object tracking. IEEE Transactions on Pattern Analysis and Machine Intelligence, 25(5), pp. 564–577, 2003. [38] B. Georgescu, D. Comaniciu, T. X. Han, and X. S. Zhou. Multi-model component-based tracking using robust information fusion. In 2nd Workshop on Statistical Methods in Video Processing, May 2004. [39] J. Vermaak, N. Lawrence, and P. Perez. Variational inference for visual tracking. In Proceedings of IEEE Conference on Computer Vision and Pattern Recognition, volume 1, pages 773–780, 2003. [40] S. Agarwal, A. Awan, and D. Roth. Learning to detect objects in images via a sparse, part- based representation. Transactions on Pattern Analysis and Machine Intelligence, 26(11), pages. 1475–1490, 2004. TẠP CHÍ KHOA HỌC VÀ CÔNG NGHỆ, Trường Đại học Khoa học, ĐH Huế Tập 18, Số 1 (2021) 21 VISUAL OBJECT TRACKING FROM VIDEO DATA USING ONLINE LEARNING Nguyen Dang Binh Faculty of Information Technology, University of Sciences, Hue University Email: ndbinh@husc.edu.vn ABSTRACT Visual object tracking is an important problem in computer vision. The main contributions are: (1) an efficient visual object learning algorithm based on online boosting, which provides a reliable object detector for the tracking process; (2) a robust strategy to deal with tracking failures and recovery of such failures. Our idea is to incorporate decision given by the prior learned strong detector and an on-line boosting tracker. This completely allows the prevention of the drifting problem in tracking problem. Experiments based on challenging datasets for a number of applications show high performance including high accuracy, on-line speed and the effectiveness of the proposed method. Keywords: visual object tracking, online learning. Nguyễn Đăng Bình Sinh ngày 08/11/1974 tại Thừa Thiên Huế. Năm 1996, ông tốt nghiệp Đại học ngành Toán - Tin tại Trường Đại học Sư phạm, Đại học Huế. Ông nhận bằng thạc sỹ Công nghệ thông tin tại Trường Đại học Bách Khoa Hà Nội năm 2022; nhận học vị Tiến sĩ ngành Công nghệ thông tin tại Viện Công nghệ Kyushu, Nhật Bản, và hoàn thành nghiên cứu Sau tiến sĩ tại Viện Thị giác và Đồ họa máy tính năm 2008 tại Đại học Công nghệ Graz, Cộng hòa Áo. Hiện ông công tác tại khoa Công nghệ Thông tin, Trường Đại học Khoa học, Đại học Huế. Lĩnh vực nghiên cứu: Học máy, Thị giác máy tính, Nhận dạng và Xử lý ảnh số. Theo dõi đối tượng trực quan từ dữ liệu video sử dụng học trực tuyến 22

File đính kèm:

theo_doi_doi_tuong_truc_quan_tu_du_lieu_video_su_dung_hoc_tr.pdf

theo_doi_doi_tuong_truc_quan_tu_du_lieu_video_su_dung_hoc_tr.pdf