Điều khiển tối ưu thích nghi trên cơ sở học tăng cường tích phân trực tuyến

Bài báo này đề xuất một cách tiếp cận trực tuyến để điều khiển tối ưu thích nghi trực

tiếp với chi phí vô hạn cho các hệ thống phi tuyến trong một khung thời gian liên tục. Sự hội tụ của

thuật toán trực tuyến với các giải pháp điều khiển tối ưu mà không yêu cầu động học nội của hệ thống.

Tính ổn định động vòng kín được đảm bảo. Thuật toán được xây dựng trên chương trình học tăng

cường (RL), cụ thể là thuật toán lặp PI (Policy Iteration) và sử dụng mạng nơ-ron trong cấu trúc

Actor/Critic để biểu diễn thông số của luật điều khiển và hiệu suất của hệ thống điều khiển. Hai mạng

nơ-ron được huấn luyện để thể hiện bộ điều khiển tối ưu và hàm chi phí tối ưu mô tả hiệu suất của bộ

điều khiển vô hạn. Kết quả là một cấu trúc điều khiển lai trong đó gồm một bộ điều khiển liên tục

theo thời gian và một cấu trúc điều khiển thích nghi giám sát hoạt động dựa trên dữ liệu được lấy mẫu

từ đối tượng và hiệu suất động học thời gian liên tục. Các phân tích lý thuyết và kết quả mô phỏng

chứng minh sự hiệu quả của thuật toán đề xuất.

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Tóm tắt nội dung tài liệu: Điều khiển tối ưu thích nghi trên cơ sở học tăng cường tích phân trực tuyến

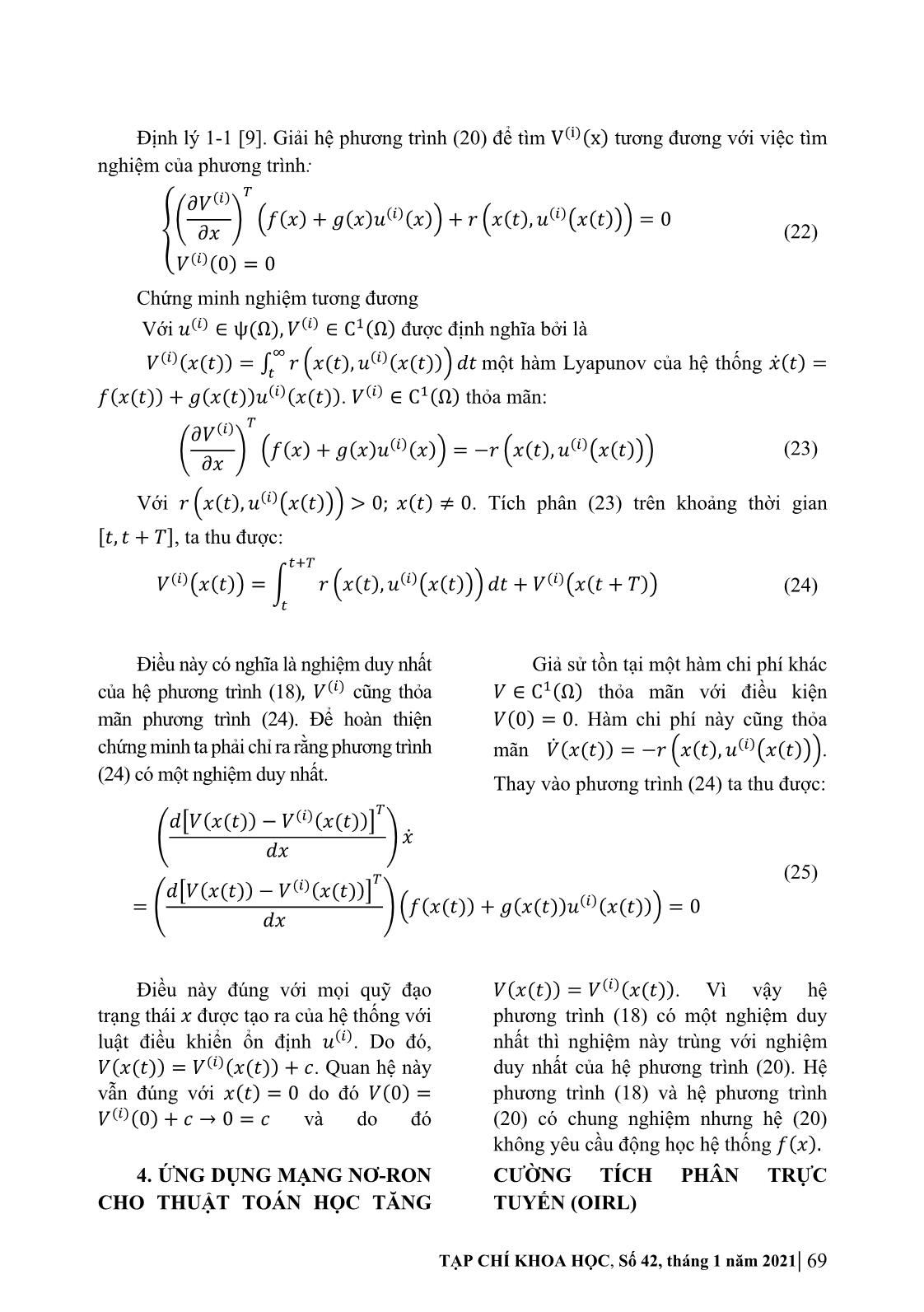

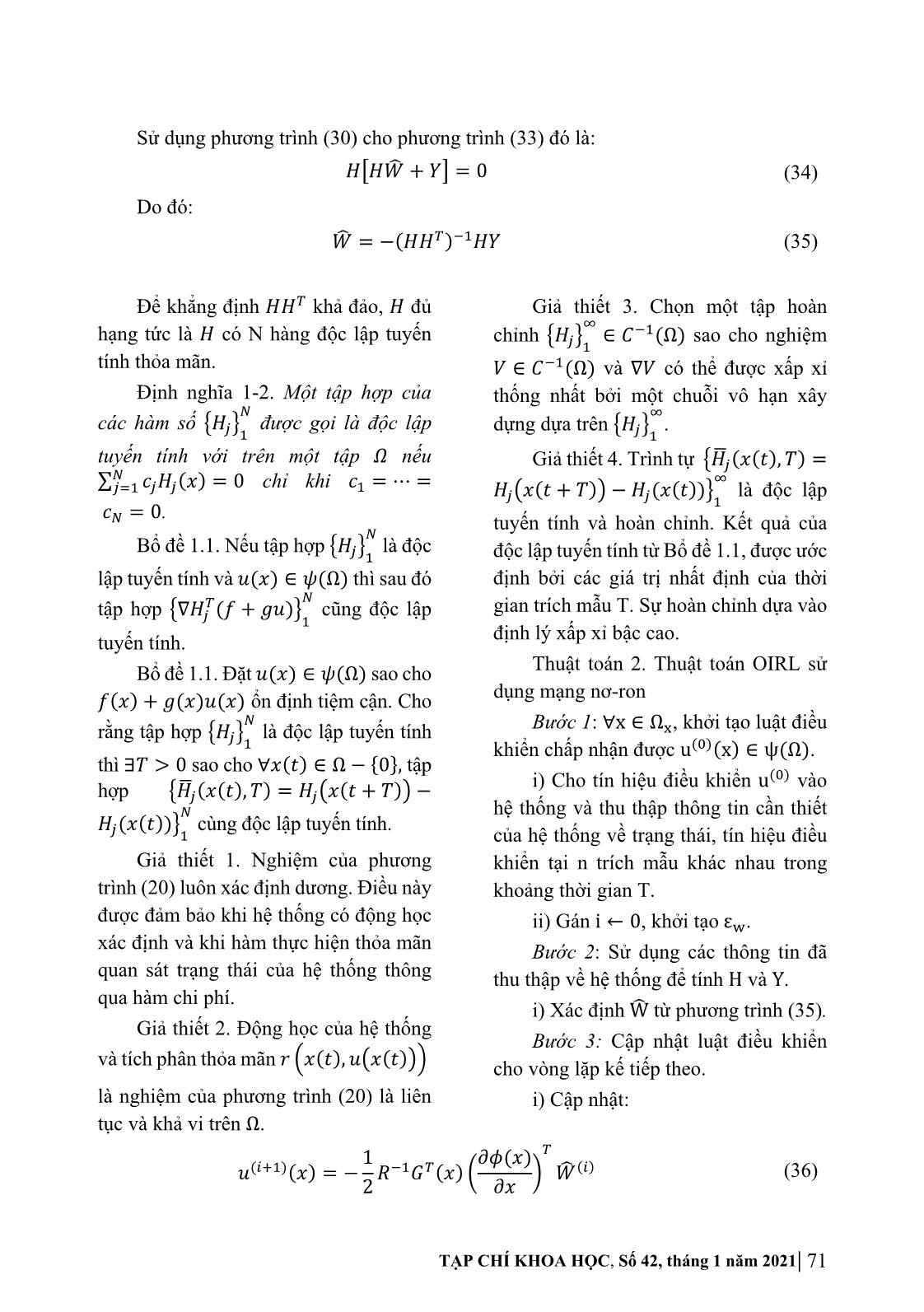

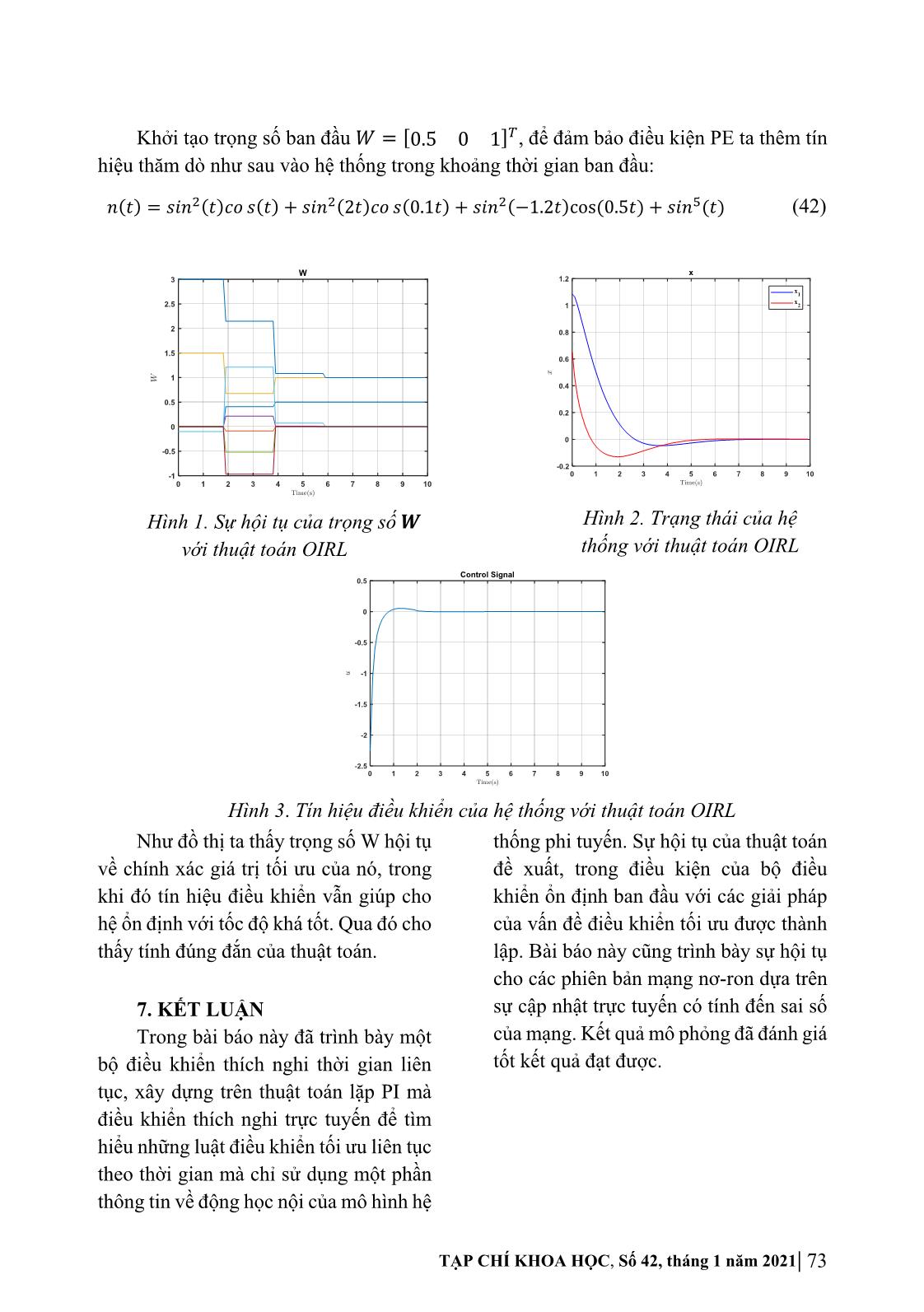

= (𝑉�) (𝑓(𝑥) +𝑔(𝑥)𝑢) +𝑄(𝑥) +𝑢 𝑅𝑢 (9) Hàm chi phí tối ưu 𝑉∗�𝑥(𝑡)� được định nghĩa dựa vào (3) [3]: � 𝑉∗�𝑥(𝑡)�= min �𝑟(𝑥,) 𝑢 𝑑𝑡 (10) ( ) � � ∈�(�) � Sử dụng định nghĩa đạo hàm và phương trình phi tuyến (1) biến đổi phương trình (10) ta có: ∗ � min�(𝑉� ) 𝑥� +𝑟(𝑥,) 𝑢 �=0 �∈� ∗ (11) min�𝑉� (𝑓(𝑥) +𝑔(𝑥)𝑢) +𝑟(𝑥,)� 𝑢 =0 �∈� ∗ ∗ Trong đó 𝑉� =𝜕𝑉 /𝜕𝑥. Dựa vào biểu thức (9) xây dựng được hàm Hamilton tối ưu như sau: ∗ ∗ � 𝐻(𝑥, 𝑢,� 𝑉 ) = (𝑉� ) (𝑓(𝑥) +𝑔(𝑥)𝑢) +𝑟(𝑥,) 𝑢 (12) Xét bộ điều khiển tối ưu 𝑢∗(𝑥) khi hàm chi phí tối ưu 𝑉∗(𝑥) thỏa mãn (10) khi đó: � 𝑢∗(𝑥) =argmin�𝑟(𝑥,) 𝑢 𝑑𝑡 (13) �(�)∈�(�) � Theo [8] luật điều khiển 𝑢∗(𝑥) ứng với (13) cũng thỏa mãn phương trình sau: ∗ ∗ ∗ 𝐻(𝑥, 𝑢 ,𝑉� ) =min𝐻(𝑥, 𝑢,� 𝑉 ) �∈� (14) Từ phương trình (11) và phương trình (12) ta có phương trình HJB [3]: ∗ min𝐻(𝑥, 𝑢,� 𝑉 ) =0 �∈� (15) Dựa vào biểu thức (13) thu được bộ điều khiển tối ưu 𝑢∗(𝑥): ∗ ∗ 𝑢 (𝑥) =argmin�𝐻(𝑥, 𝑢,� 𝑉 )� (16) �∈� Luật điều khiển tối ưu xác định: 1 𝜕𝑉∗(𝑥) 1 𝑢∗(𝑥) =− 𝑅��𝑔�(𝑥) =− 𝑅��𝑔�(𝑥)𝑉∗ (17) 2 𝜕𝑥 2 � Sử dụng phương trình (17) vào phương trình (15) và 𝑟(𝑥,) 𝑢 =𝑄(𝑥) +𝑢�𝑅𝑢, ta ∗ được phương trình HJB theo tham số 𝑉� như sau [3]: 1 (𝑉∗)�𝑓(𝑥) − (𝑉∗)�𝑔(𝑥)𝑅��𝑔�(𝑥)𝑉∗ +𝑥�𝑄𝑥 =0 � 4 � � (18) 𝑉∗(0) = 0 TẠP CHÍ KHOA HỌC, Số 42, tháng 1 năm 2021| 67 3. THUẬT TOÁN LẶP PI ĐỂ GIẢI QUYẾT PHƯƠNG TRÌNH HJB Thay vì chuyển phương trình HJB (18) về dạng phương trình vi phân, để phương trình HJB ở dạng tích phân như sau: � 𝑉∗�𝑥(𝑡)�=min�𝑟(𝑥,) 𝑢 𝑑𝑡 �∈� � ��� = min ��𝑟(𝑥,) 𝑢 𝑑𝑡 +𝑉∗�𝑥(𝑡+𝑇)�� (19) �∈� � ��� = � 𝑟(𝑥,∗ 𝑢 )𝑑𝑡 +𝑉∗�𝑥(𝑡+𝑇)� � Với 𝑢(�)(𝑥(𝑡)) ∈ ψ(Ω) là luật điều của hệ thống về trạng thái, tín hiệu điều khiển chấp nhận được và 𝑇>0, cũng khiển tại n trích mẫu khác nhau trong như 𝑥(𝑡) ∈Ω,𝑥(𝑡+𝑇) ∈Ω chuyển khoảng thời gian T. sang dạng IRL như sau: ii) Gán i←0. Thuật toán 1 [9]. Thuật toán lặp PI Bước 2: Sử dụng các thông tin đã (Online On-Policy IRL) thu thập về hệ thống nhằm xấp xỉ hàm (�) Bước 1: ∀x ∈ Ω�, khởi tạo luật điều V (x) ở bước i với các tín hiệu điều khiển chấp nhận được u(�)(x) và giá trị khiển vào hệ thống là u(�)(x). V(�)(x) =0. i) Xác định V(�)(x) từ hệ phương trình: i) Cho tín hiệu điều khiển u(�) vào hệ thống và thu thập thông tin cần thiết ��� 𝑉(�)(𝑥) =� 𝑟�𝑥,𝑢(�)�𝑑𝑡 +𝑉(�)�𝑥(𝑡+𝑇)� � � (20) 𝑉(�)(0) = 0 Bước 3: Cập nhật luật điều khiển cho vòng lặp kế tiếp theo. i) Cập nhật: 1 𝜕𝑉(�)(𝑥) 𝑢(���)(𝑥) =− 𝑅��𝐺�(𝑥) (21) 2 𝜕𝑥 ii) Nếu thỏa mãn tiêu chuẩn hội tụ sao cho �V(�)(x) −V∗(x)�<ε, với ε là số dương đủ nhỏ thì gán u∗(x) =u(���)(x) và V∗(x) =V(�)(x), kết thúc giải thuật. iii) Nếu không thỏa mãn, gán i←i+1, cho tín hiệu u(�) vào hệ thống và thu thập thông tin cần thiết của hệ thống về trạng thái, tín hiệu điều khiển tại n trích mẫu khác nhau trong khoảng thời gian T rồi quay lại bước 2. Phương trình (20) được coi là phương trình Lyapunov dạng tích phân. Sự hội tụ của thuật toán IRL được đảm bảo thông qua định lý dưới đây: 68 | Tạp chí khoa học, Số 42, tháng 9 năm 2020 Định lý 1-1 [9]. Giải hệ phương trình (20) để tìm V(�)(x) tương đương với việc tìm nghiệm của phương trình: � 𝜕𝑉(�) � � �𝑓(𝑥) +𝑔(𝑥)𝑢(�)(𝑥)�+𝑟�𝑥(𝑡),𝑢(�)�𝑥(𝑡)�� = 0 � 𝜕𝑥 (22) 𝑉(�)(0) = 0 Chứng minh nghiệm tương đương Với 𝑢(�) ∈ ψ(Ω), 𝑉(�) ∈C�(Ω) được định nghĩa bởi là (�)( ) � (�)( ) ( ) 𝑉 𝑥(𝑡) = �� 𝑟�𝑥(𝑡),𝑢 𝑥(𝑡) �𝑑𝑡 một hàm Lyapunov của hệ thống 𝑥� 𝑡 = 𝑓(𝑥(𝑡)) +𝑔(𝑥(𝑡))𝑢(�)(𝑥(𝑡)). 𝑉(�) ∈C�(Ω) thỏa mãn: � 𝜕𝑉(�) � � �𝑓(𝑥) +𝑔(𝑥)𝑢(�)(𝑥)�=−𝑟�𝑥(𝑡),𝑢(�)�𝑥(𝑡)�� (23) 𝜕𝑥 Với 𝑟�𝑥(𝑡),𝑢(�)�𝑥(𝑡)�� > 0; 𝑥(𝑡) ≠0. Tích phân (23) trên khoảng thời gian �𝑡, 𝑡� +𝑇 , ta thu được: ��� 𝑉(�)�𝑥(𝑡)�=� 𝑟�𝑥(𝑡),𝑢(�)�𝑥(𝑡)�� 𝑑𝑡 +𝑉(�)�𝑥(𝑡+𝑇)� (24) � Điều này có nghĩa là nghiệm duy nhất Giả sử tồn tại một hàm chi phí khác của hệ phương trình (18), 𝑉(�) cũng thỏa 𝑉∈C�(Ω) thỏa mãn với điều kiện mãn phương trình (24). Để hoàn thiện 𝑉(0) =0. Hàm chi phí này cũng thỏa chứng minh ta phải chỉ ra rằng phương trình mãn 𝑉� (𝑥(𝑡)) =−𝑟�𝑥(𝑡),𝑢(�)�𝑥(𝑡)��. (24) có một nghiệm duy nhất. Thay vào phương trình (24) ta thu được: � 𝑑�𝑉(𝑥(𝑡)) −𝑉(�)(𝑥(𝑡))� � � 𝑥� 𝑑𝑥 � (25) 𝑑�𝑉(𝑥(𝑡)) −𝑉(�)(𝑥(𝑡))� = � � �𝑓(𝑥(𝑡)) +𝑔(𝑥(𝑡))𝑢(�)(𝑥(𝑡))�=0 𝑑𝑥 Điều này đúng với mọi quỹ đạo 𝑉(𝑥(𝑡)) =𝑉(�)(𝑥(𝑡)). Vì vậy hệ trạng thái 𝑥 được tạo ra của hệ thống với phương trình (18) có một nghiệm duy luật điều khiển ổn định 𝑢(�). Do đó, nhất thì nghiệm này trùng với nghiệm 𝑉(𝑥(𝑡)) =𝑉(�)(𝑥(𝑡)) +𝑐. Quan hệ này duy nhất của hệ phương trình (20). Hệ vẫn đúng với 𝑥(𝑡) =0 do đó 𝑉(0) = phương trình (18) và hệ phương trình 𝑉(�)(0) +𝑐→0=𝑐 và do đó (20) có chung nghiệm nhưng hệ (20) không yêu cầu động học hệ thống 𝑓(𝑥). 4. ỨNG DỤNG MẠNG NƠ-RON CƯỜNG TÍCH PHÂN TRỰC CHO THUẬT TOÁN HỌC TĂNG TUYẾN (OIRL) TẠP CHÍ KHOA HỌC, Số 42, tháng 1 năm 2021| 69 Áp dụng khả năng xấp xỉ của mạng Trong đó 𝑊� � ∈ℝ� là ma trận trọng Nơ-ron đồng thời nhằm giảm khối lượng số lý tưởng chưa biết, 𝑁 là số nơ-ron, � tính toán so với cấu trúc Actor – Critic, 𝜙(𝑥) = �𝜙�(𝑥),𝜙�(𝑥) ,𝜙�(𝑥)� ∈ giải thuật này sử dụng một mạng Nơ-ron ℝ� là véc-tơ các hàm cơ bản phù hợp. nhằm xấp xỉ hàm chi phí tối ưu 𝑉(𝑥) với Sử dụng mạng nơ-ron xấp xỉ cho 𝑥∈Ω như sau: hàm chi phí tối ưu, thay công thức (26) 𝑉�(𝑥) =𝑊� �𝜙(𝑥) (26) vào công thức (20) thu được: ��� 𝑊� �𝜙�𝑥(𝑡)�=� 𝑟�𝑥,𝑢(�)�𝑑𝑡� +𝑊�𝜙�𝑥(𝑡+𝑇)� (27) � Xuất hiện sai lệch 𝑒(𝑡) là sai số xấp xỉ của hàm Bellman. ��� 𝑒(𝑥(𝑡),𝑇) =𝑊� � �𝜙�𝑥(𝑡+𝑇)�−𝜙�𝑥(𝑡)�� = − � 𝑟�𝑥, 𝑢(�)�𝑑𝑡 (28) � Ta đặt công thức: ℎ(𝑡) =𝜙�𝑥(𝑡+𝑇)�−𝜙�𝑥(𝑡)� ��� (29) 𝑦(𝑡) =� 𝑟�𝑥,𝑢(�)�𝑑𝑡 � Phương trình (28) được viết lại như sau: 𝐻=�ℎ(𝑡�),,ℎ(𝑡�)� � � (31) 𝑒(𝑡) =𝑊� ℎ(𝑡) +𝑦(𝑡) (30) 𝑌=�𝑦(𝑡�),,𝑦(𝑡�)� Chỉnh định tham số 𝑊� để tối thiểu Việc thu thập dữ liệu để giải xấp xỉ hóa đại lượng bình phương sai (27) yêu cầu tập dữ liệu thỏa mãn ma trận lệch 𝑒�(𝑡). Phương trình (30) là hàm 𝐻 đủ hạng túc là 𝐻�𝐻 khả nghịch. Để tuyến tính đối với tham số 𝑊� . Do đó ta xác định các trọng số 𝑊� của mạng nơ- có thể áp dụng thuật toán cực tiểu hóa ron xấp xỉ hàm chi phí 𝑉� (�)(𝑥) dẫn tới để bình phương sai lệch (Least Square tối thiểu hóa hàm mục tiêu sau đây: Error) để tìm giá trị tối ưu cho 𝑊� . Thông tin của hệ thống được thu 𝑆=�( 𝑒 𝑥,) 𝑇 𝑒(𝑥,) 𝑇 𝑑𝑥 (32) � thập N trích mẫu khác nhau trong khoảng thời gian T do đó ta tính toán (29) tại n điểm từ 𝑡� →𝑡� thu được các hàm: Thực chất của việc tối thiểu hóa 〈 〉 tích 𝑓, 𝑔 = �� 𝑓𝑔𝑑𝑥 của tích phân công thức (32) thỏa mãn phương trình Lebesgue có thể viết: ��(�,�) sau � 𝑒(𝑥,) 𝑇 𝑑𝑥 =0. Sử dụng � � �� (�) 𝑑𝑒(𝑥,) 𝑇 � ,𝑒(𝑥,) 𝑇 � =0 (33) 𝑑 � 𝑊 � 70 | Tạp chí khoa học, Số 44, tháng 1 năm 2021 Sử dụng phương trình (30) cho phương trình (33) đó là: 𝐻�𝐻𝑊� +𝑌�=0 (34) Do đó: 𝑊� =−(𝐻𝐻�)��𝐻𝑌 (35) Để khẳng định 𝐻𝐻� khả đảo, 𝐻 đủ Giả thiết 3. Chọn một tập hoàn � hạng tức là 𝐻 có N hàng độc lập tuyến chỉnh �𝐻 � ∈𝐶��(Ω) sao cho nghiệm � � tính thỏa mãn. 𝑉∈𝐶��(Ω) và ∇𝑉 có thể được xấp xỉ Định nghĩa 1-2. Một tập hợp của thống nhất bởi một chuỗi vô hạn xây � � các hàm số �𝐻 � được gọi là độc lập dựng dựa trên �𝐻 � . � � � � tuyến tính với trên một tập 𝛺 nếu Giả thiết 4. Trình tự �𝐻��(𝑥(𝑡),𝑇) = � � ∑��� 𝑐�𝐻�(𝑥) =0 chỉ khi 𝑐� =⋯= 𝐻��𝑥(𝑡+𝑇)�−𝐻�(𝑥(𝑡))� là độc lập 𝑐 =0. � � tuyến tính và hoàn chỉnh. Kết quả của � Bổ đề 1.1. Nếu tập hợp �𝐻 � là độc � � độc lập tuyến tính từ Bổ đề 1.1, được ước lập tuyến tính và 𝑢(𝑥) ∈ 𝜓(Ω) thì sau đó định bởi các giá trị nhất định của thời � tập hợp �∇𝐻�(𝑓 + 𝑔𝑢)� cũng độc lập gian trích mẫu T. Sự hoàn chỉnh dựa vào � � tuyến tính. định lý xấp xỉ bậc cao. Bổ đề 1.1. Đặt 𝑢(𝑥) ∈ 𝜓(Ω) sao cho Thuật toán 2. Thuật toán OIRL sử 𝑓(𝑥) + 𝑔(𝑥)𝑢(𝑥) ổn định tiệm cận. Cho dụng mạng nơ-ron � Bước 1: ∀x ∈ Ω�, khởi tạo luật điều rằng tập hợp �𝐻�� là độc lập tuyến tính � khiển chấp nhận được u(�)(x) ∈ ψ(Ω). thì ∃𝑇 > 0 sao cho ∀𝑥(𝑡) ∈Ω−�0�, tập i) Cho tín hiệu điều khiển u(�) vào hợp �𝐻��(𝑥(𝑡),𝑇) =𝐻��𝑥(𝑡+𝑇)�− � hệ thống và thu thập thông tin cần thiết 𝐻 (𝑥(𝑡))� cùng độc lập tuyến tính. � � của hệ thống về trạng thái, tín hiệu điều Giả thiết 1. Nghiệm của phương khiển tại n trích mẫu khác nhau trong trình (20) luôn xác định dương. Điều này khoảng thời gian T. được đảm bảo khi hệ thống có động học ii) Gán i←0, khởi tạo ε�. xác định và khi hàm thực hiện thỏa mãn Bước 2: Sử dụng các thông tin đã quan sát trạng thái của hệ thống thông thu thập về hệ thống để tính H và Y. qua hàm chi phí. i) Xác định W� từ phương trình (35). Giả thiết 2. Động học của hệ thống Bước 3: Cập nhật luật điều khiển ( ) ( ) và tích phân thỏa mãn 𝑟�𝑥 𝑡 ,𝑢�𝑥 𝑡 �� cho vòng lặp kế tiếp theo. là nghiệm của phương trình (20) là liên i) Cập nhật: tục và khả vi trên Ω. 1 𝜕𝜙(𝑥) � 𝑢(���)(𝑥) =− 𝑅��𝐺�(𝑥) � � 𝑊� (�) (36) 2 𝜕𝑥 TẠP CHÍ KHOA HỌC, Số 42, tháng 1 năm 2021| 71 ii) Nếu thỏa mãn tiêu chuẩn hội tụ 5. PHÂN TÍCH TÍNH HỘI TỤ (���) (�) sao cho �W� −W� �<ε�, kết thúc VÀ ỔN ĐỊNH CỦA THUẬT TOÁN giải thuật. Định lý 1-2. Thuật toán lặp PI (20) iii) Nếu không thỏa mãn, gán i← và (21) hội tụ về nghiệm tối ưu trên quỹ i+1, cho tín hiệu u(�) vào hệ thống và đạo trạng thái 𝛺 tức là với mọi 𝜀>0 tồn thu thập thông tin cần thiết của hệ thống tại 𝑖�,𝐿� sao cho với mọi 𝑖≥𝑖� thì ta đều về trạng thái, tín hiệu điều khiển tại n có: trích mẫu khác nhau trong khoảng thời gian T rồi quay lại bước 2. (�) ∗ (�) ∗ sup�𝑉 (𝑥) −𝑉 (𝑥)�<𝜀, sup�𝑢 (𝑥) −𝑢 (𝑥)�<𝜀 (37) �∈� �∈� Chứng minh Dựa trên sự tương đương về nghiệm Trong các tài liệu [1], đã chứng đã được chứng minh giữ các phương minh rằng lặp đi lặp lại trên các phương trình (20) và (22), chúng ta có thể kết trình (21) và (22) với điều kiện đầu luận rằng giải thuật điều khiển tối ưu trực 𝑢(�)(𝑥) tất cả các luật điều khiển tuần tự tuyến sẽ hội tụ đến nghiệm của bài toán sẽ được chấp nhận và sự lặp (21) và (22) tối ưu (3) trong Ω mà không cần sử dụng sẽ hội tụ đến nghiệm của phương trình kiến thức về động học bên trong của hệ HJB có nghĩa là đồng thời thỏa mãn thống điều khiển (1). phương trình (37). 6. MÔ PHỎNG TRÊN HỆ PHI TUYẾN BẬC 2 Xét hệ phi tuyến affne: −𝑥� +𝑥� 0 𝑥� =� � �+� �u (38) −0.5𝑥�−0.5𝑥�(1−(cos(2𝑥�) +2) ) cos(2𝑥�) +2 với hàm mục tiêu: � 𝐽=� (𝑥�𝑄𝑥 +𝑢�𝑅𝑢)𝑑𝑡 � (39) 10 𝑄(𝑥) =� �;𝑅 =1 01 Giải phương trình HJB ta thu được hàm Bellman và tín hiệu điều khiển tối ưu: 1 𝑉∗(𝑥) = 𝑥� +𝑥� 2 � � (40) ∗ � 𝑢 (𝑥) =−(cos(2𝑥�) +2)𝑥� Nhằm chứng minh tính đúng đắn thuật toán, ta chọn hàm tác động của hai mạng NNs có dạng: � � � 𝜙(𝑥) = �𝑥� 𝑥�𝑥� 𝑥� � (41) 72 | Tạp chí khoa học, Số 44, tháng 1 năm 2021 Khởi tạo trọng số ban đầu 𝑊=�0.501��, để đảm bảo điều kiện PE ta thêm tín hiệu thăm dò như sau vào hệ thống trong khoảng thời gian ban đầu: 𝑛(𝑡) =𝑠𝑖𝑛�(𝑡)𝑐𝑜 𝑠(𝑡) +𝑠𝑖𝑛�(2𝑡)𝑐𝑜 𝑠(0.1𝑡) +𝑠𝑖𝑛�(−1.2𝑡)cos(0.5𝑡) + 𝑠𝑖𝑛�(𝑡) (42) W x 3 1.2 x 1 x 2.5 1 2 2 0.8 1.5 0.6 1 0.4 0.5 0.2 0 0 -0.5 -0.2 -1 012345678910 012345678910 Hình 1. Sự hội tụ của trọng số 𝑾 Hình 2. Trạng thái của hệ với thuật toán OIRL thống với thuật toán OIRL Control Signal 0.5 0 -0.5 -1 -1.5 -2 -2.5 012345678910 Hình 3. Tín hiệu điều khiển của hệ thống với thuật toán OIRL Như đồ thị ta thấy trọng số W hội tụ thống phi tuyến. Sự hội tụ của thuật toán về chính xác giá trị tối ưu của nó, trong đề xuất, trong điều kiện của bộ điều khi đó tín hiệu điều khiển vẫn giúp cho khiển ổn định ban đầu với các giải pháp hệ ổn định với tốc độ khá tốt. Qua đó cho của vấn đề điều khiển tối ưu được thành thấy tính đúng đắn của thuật toán. lập. Bài báo này cũng trình bày sự hội tụ cho các phiên bản mạng nơ-ron dựa trên 7. KẾT LUẬN sự cập nhật trực tuyến có tính đến sai số Trong bài báo này đã trình bày một của mạng. Kết quả mô phỏng đã đánh giá bộ điều khiển thích nghi thời gian liên tốt kết quả đạt được. tục, xây dựng trên thuật toán lặp PI mà điều khiển thích nghi trực tuyến để tìm hiểu những luật điều khiển tối ưu liên tục theo thời gian mà chỉ sử dụng một phần thông tin về động học nội của mô hình hệ TẠP CHÍ KHOA HỌC, Số 42, tháng 1 năm 2021| 73 TÀI LIỆU THAM KHẢO systems using policy iteration and neural 1. Murad Abu-Khalaf and Frank L networks,” IEEE Transactions on Neural Lewis (2005), “Nearly optimal control laws Networks and Learning Systems, vol. 24, no. for nonlinear systems with saturating actuators 10. pp. 1513–1525. using a neural network hjb approach,” 6. J. B. P. and Y. H. C. J. Y. Lee Automatica, vol. 41(5), pp. 779–791. (2015), “Integral Reinforcement Learning 2. F. L. Draguna Vrabie (2009), “Neural for Continuous-Time Input-Affine network approach to continuous-time direct Nonlinear Systems With Simultaneous adaptive optimal control for partially unknown Invariant Explorations,” IEEE Trans. nonlinear systems,” Neural Networks, vol. 22, Neural Networks Learn. Syst., vol. 26, no. 5, no. 3, pp. 237–246. pp. 916–932. 3. K. G. Vamvoudakis and F. L. Lewis 7. K. G. Vamvoudakis (2011), “Online (2009), “Online actor critic algorithm to learning algorithms for differential dynamic solve the continuous-time infinite horizon games and optimal control,” Ph.D. Thesis, optimal control problem,” Proceedings of Univ. Texas Arlingt. the International Joint Conference on 8. D. L. V. and V. L. S. Frank L. Lewis Neural Networks. pp. 3180–3187. (2012), “Optimal Control,” John Wiley 4. M. and Bhasin, Shubhendu and Sons, Inc. Kamalapurkar, Rushikesh and Johnson and 9. K. G. Vamvoudakis, D. Vrabie, and W. E. Vamvoudakis, Kyriakos G and Lewis, F. L. Lewis (2011), “Online adaptive Frank L and Dixon (2013), “A novel actor- learning of optimal control solutions using critic-identifier architecture for approximate integral reinforcement learning,” IEEE SSCI optimal control of uncertain nonlinear 2011: Symposium Series on Computational systems,” Automatica, vol. 49(1), pp. 82–92. Intelligence - ADPRL 2011: 2011 IEEE 5. H. Modares, F. L. Lewis, and M. B. Symposium on Adaptive Dynamic Naghibi-Sistani (2013), “Adaptive optimal Programming and Reinforcement Learning. control of unknown constrained-input pp. 250–257. 74 | Tạp chí khoa học, Số 44, tháng 1 năm 2021

File đính kèm:

dieu_khien_toi_uu_thich_nghi_tren_co_so_hoc_tang_cuong_tich.pdf

dieu_khien_toi_uu_thich_nghi_tren_co_so_hoc_tang_cuong_tich.pdf