Đảm bảo tính riêng tư dữ liệu với học liên kết cải tiến

TÓM TẮT

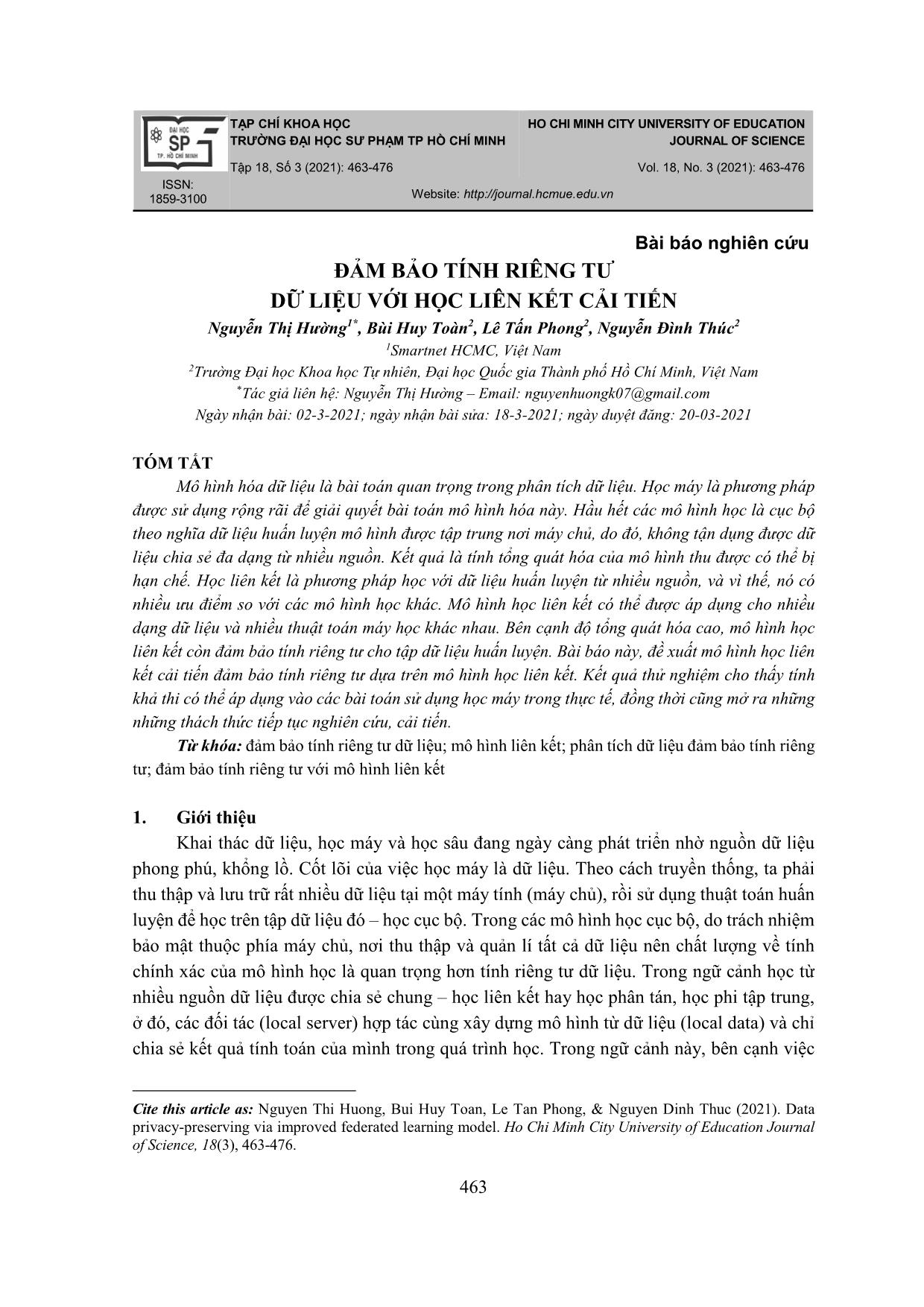

Mô hình hóa dữ liệu là bài toán quan trọng trong phân tích dữ liệu. Học máy là phương pháp

được sử dụng rộng rãi để giải quyết bài toán mô hình hóa này. Hầu hết các mô hình học là cục bộ

theo nghĩa dữ liệu huấn luyện mô hình được tập trung nơi máy chủ, do đó, không tận dụng được dữ

liệu chia sẻ đa dạng từ nhiều nguồn. Kết quả là tính tổng quát hóa của mô hình thu được có thể bị

hạn chế. Học liên kết là phương pháp học với dữ liệu huấn luyện từ nhiều nguồn, và vì thế, nó có

nhiều ưu điểm so với các mô hình học khác. Mô hình học liên kết có thể được áp dụng cho nhiều

dạng dữ liệu và nhiều thuật toán máy học khác nhau. Bên cạnh độ tổng quát hóa cao, mô hình học

liên kết còn đảm bảo tính riêng tư cho tập dữ liệu huấn luyện. Bài báo này, đề xuất mô hình học liên

kết cải tiến đảm bảo tính riêng tư dựa trên mô hình học liên kết. Kết quả thử nghiệm cho thấy tính

khả thi có thể áp dụng vào các bài toán sử dụng học máy trong thực tế, đồng thời cũng mở ra những

những thách thức tiếp tục nghiên cứu, cải tiến.

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Tóm tắt nội dung tài liệu: Đảm bảo tính riêng tư dữ liệu với học liên kết cải tiến

liên kết, đồng thời cũng cần đồng

nhất giữa các tham số trong quá trình học của các máy con. Điểm khác là thay vì liên tục

cho mô hình huấn luyện học dữ liệu, các máy con sau một khoảng thời gian học nhất định

phải gửi bộ tham số của mô hình học lên máy chủ, sau đó chờ máy chủ tổng hợp ra bộ tham

số mới, nhận bộ tham số mới đó và tiếp tục quá trình học cục bộ của mình. Như vậy, mô

hình huấn luyện của máy con đã bị chi phối bởi máy chủ, không còn mang tính cá nhân và

đã chuyển sang trạng thái tổng quát trên toàn bộ các máy con khác của mô hình học liên kết.

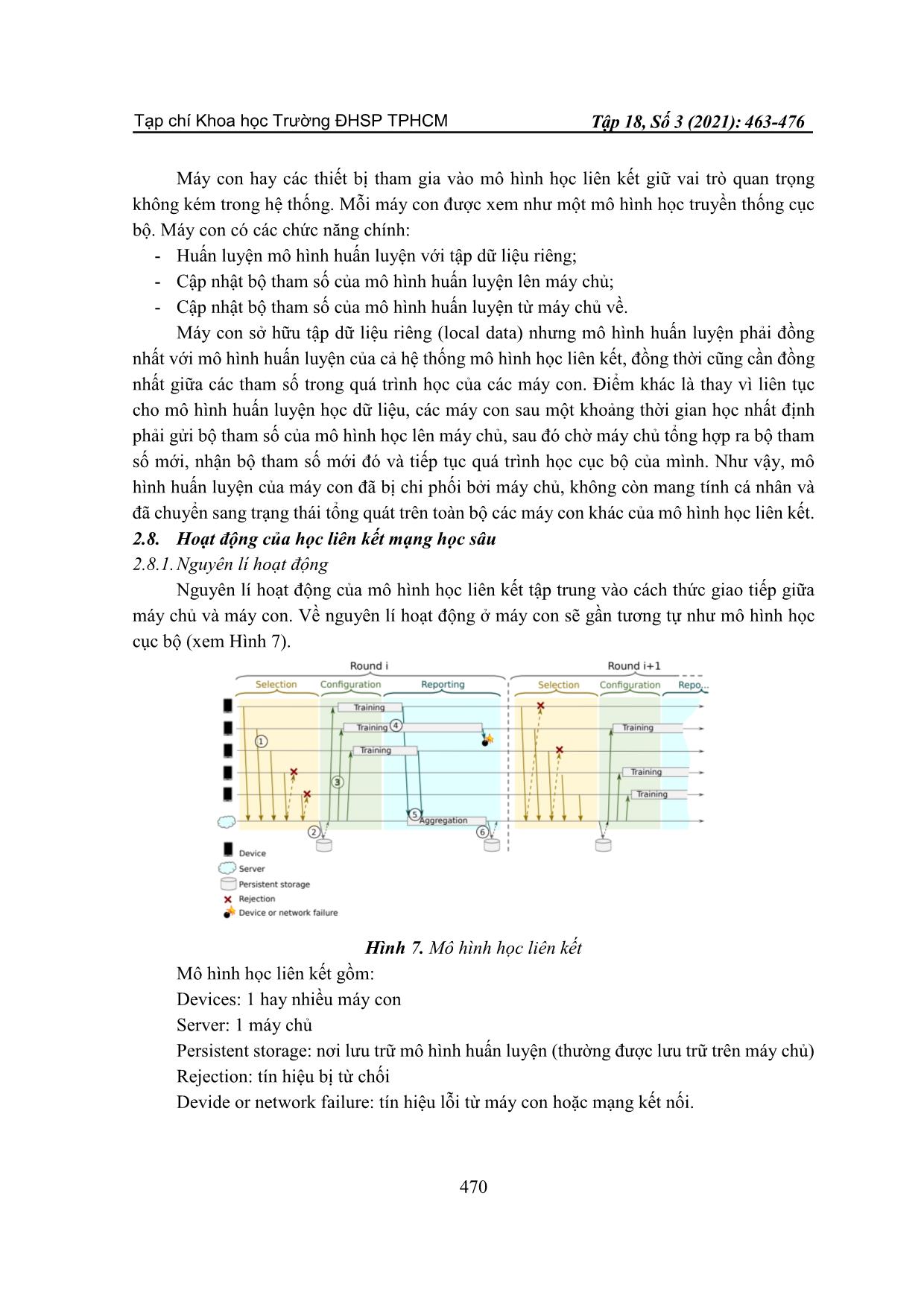

2.8. Hoạt động của học liên kết mạng học sâu

2.8.1. Nguyên lí hoạt động

Nguyên lí hoạt động của mô hình học liên kết tập trung vào cách thức giao tiếp giữa

máy chủ và máy con. Về nguyên lí hoạt động ở máy con sẽ gần tương tự như mô hình học

cục bộ (xem Hình 7).

Hình 7. Mô hình học liên kết

Mô hình học liên kết gồm:

Devices: 1 hay nhiều máy con

Server: 1 máy chủ

Persistent storage: nơi lưu trữ mô hình huấn luyện (thường được lưu trữ trên máy chủ)

Rejection: tín hiệu bị từ chối

Devide or network failure: tín hiệu lỗi từ máy con hoặc mạng kết nối.

Tạp chí Khoa học Trường ĐHSP TPHCM Nguyễn Thị Hường và tgk

471

Khá giống với mô hình học cục bộ ở bước học mô hình huấn luyện, quy trình học của

mô hình học liên kết cũng được chia ra nhiều vòng tổng hợp. Mỗi vòng tổng hợp là một quy

trình nhỏ, là sự trao đổi và tổng hợp bộ tham số của mô hình huấn luyện giữa máy con và

máy chủ. Chi tiết hơn, mỗi vòng tổng hợp gồm có 3 pha: pha lựa chọn, pha cấu hình và pha

báo cáo

Pha lựa chọn là pha đầu tiên trong quy trình, nó giúp máy chủ chọn ra những ứng cử

viên tham gia vào vòng tổng hợp này.

Đầu tiên, bước (1), máy chủ se ̃phát tı́n hiệu thông báo pha lưạ choṇ bắt đầu, điều này

cũng đồng nghıã với việc bắt đầu một vòng tổng hơp̣ mới. Máy con nào nhận đươc̣ tı́n hiệu

và đang ở trong traṇg thái sẵn sàng sẽ gửi thông báo sẵn sàng cho máy chủ. Những máy con

đang còn làm công việc dang dở se ̃tiếp tuc̣ làm và đơị đến thông báo cho pha lưạ choṇ sau.

Máy chủ sau một khoảng thời gian chờ nhất điṇh se ̃thu thập đươc̣ một tập hơp̣ máy con có

tı́n hiệu sẵn sàng, sau đó thưc̣ hiện choṇ ngâũ nhiên ra các máy con sẵn sàng đó với số lươṇg

nhất điṇh và gửi thông báo chấp nhận pha lưạ choṇ cho các máy con. Máy con nhận đươc̣

thông báo chấp nhận pha lưạ choṇ se ̃chuyển từ traṇg thái sẵn sàng sang traṇg thái đang hoaṭ

động và chờ nhận thống báo từ pha tiếp theo. Còn các máy con không đươc̣ choṇ thı̀ máy

chủ se ̃gửi thông báo từ chối, các máy con nhận đươc̣ thông báo từ chối se ̃tiếp tuc̣ ở traṇg

thái sẵn sàng và đơị đến pha lưạ choṇ tiếp theo. Trong trường hơp̣ hết thời gian chờ của pha

lưạ choṇ mà máy chủ không nhận đủ số lươṇg tı́n hiệu từ máy con ở traṇg thái sẵn sàng thı̀

se ̃hủy pha lưạ choṇ này, gửi thông báo từ chối tới tất cả máy con mà máy chủ đa ̃gửi thông

báo chấp nhận pha lưạ choṇ trước đó để các máy con trở laị traṇg thái sẵn sàng, đơị một

khoảng thời gian nhất điṇh và bắt đầu laị pha lưạ choṇ mới

Bắt đầu pha cấu hı̀nh, bước (2), máy chủ se ̃đoc̣ bộ tham số mô hı̀nh huấn luyện mới

nhất từ nơi lưu trữ mô hıǹh huấn luyện. Sau đó, bước (3), máy chủ gửi bộ tham số mô hı̀nh

huấn luyện cho tất cả các máy con đươc̣ choṇ từ pha lưạ choṇ trước đó. Bước (4), các máy

con sau khi nhận đươc̣ bộ tham số mô hı̀nh huấn luyện từ máy chủ se ̃áp nó vô mô hı̀nh huấn

luyện của mı̀nh và tiến hành huấn luyện mô hı̀nh huấn luyện mới đươc̣ cập nhật bằng tập dữ

liệu của mı̀nh. Ở máy con, không nhất thiết là cứ xong một vòng lặp hoc̣ cuc̣ bộ thı̀ máy con

gửi bộ tham số mà máy con có thể thưc̣ hiện một số lươṇg vòng lặp hoc̣ cuc̣ bộ nhất điṇh rồi

mới gửi bộ tham số cho máy chủ.

Pha báo cáo đươc̣ bắt đầu sau khi máy chủ thưc̣ hiện gửi bộ tham số mô hı̀nh huấn

luyện từ pha cấu hı̀nh cho tất cả các máy con hoàn tất. Ở pha này, máy chủ se ̃đơị các máy

con đươc̣ chấp nhận huấn luyện mô hı̀nh huấn luyện xong và gửi bộ tham số của mô hı̀nh

huấn luyện mới lên. Máy con gửi bộ tham số mô hı̀nh huấn luyện xong se ̃chuyển traṇg thái

sang sẵn sàng và chờ vòng tổng hơp̣ tiếp theo. Bước (5), sau khi nhận đủ tất cả bộ tham số

mô hı̀nh huấn luyện, máy chủ tiến hành tổng hơp̣ tất cả bộ tham số mô hı̀nh huấn luyện thành

một bộ tham số mô hı̀nh huấn luyện mới và bước (6), lưu trữ laị taị nơi lưu trữ mô hı̀nh huấn

luyện. Máy con có thể gửi tı́n hiệu lỗi máy con hoặc lỗi kết nối đến máy chủ khi gặp sư ̣cố

Tạp chí Khoa học Trường ĐHSP TPHCM Tập 18, Số 3 (2021): 463-476

472

về quá trı̀nh huấn luyện mô hı̀nh huấn luyện hoặc về kết nối, máy chủ nhận đươc̣ tı́n hiệu lỗi

se ̃bỏ qua máy con đó. Máy con gửi tı́n hiệu lỗi dừng moị hoaṭ động laị và chuyển sang traṇg

thái sẵn sàng để chờ vòng tổng hơp̣ mới. Trong trường hơp̣ hết thời gian chờ của pha báo

cáo mà máy chủ vâñ chưa nhận đủ bộ tham số mô hı̀nh huấn luyện của các máy con, máy

chủ se ̃gửi tı́n hiệu hết thời gian thông báo cho các máy con chậm trê,̃ sau đó tı́nh tổng các

máy con đa ̃gửi bộ tham số mô hı̀nh huấn luyện nếu đủ số lươṇg thı̀ se ̃tiến hành tổng hơp̣

như bı̀nh thường, còn không se ̃hủy pha báo cáo này và dừng vòng tổng hơp̣ laị, bắt đầu vòng

tổng hơp̣ mới

2.8.2. Tổng hợp bộ tham số mô hình huấn luyện

Trong máy học, các thuật toán mạng nơ-ron có thể biểu diễn dưới dạng hàm 𝑖𝑖(𝑥𝑥) với

bộ tham số là tập hợp 𝑤𝑤 = {𝑤𝑤1,𝑤𝑤2, ,𝑤𝑤𝑘𝑘} với k là số lượng tham số có trong hàm 𝑖𝑖(𝑥𝑥).

Đây cũng chính là bộ tham số mà máy chủ và máy con truyền nhận cho nhau và tại máy chủ

sự tổng hợp cũng diễn ra trên bộ tham số này.

𝑤𝑤𝑡𝑡𝑡𝑡 = �𝑤𝑤1,𝑤𝑤2, ,𝑤𝑤𝑘𝑘|𝑤𝑤𝑖𝑖 = 1𝑡𝑡�𝑤𝑤𝑗𝑗𝑖𝑖 𝑣𝑣ớ𝑖𝑖 𝑖𝑖 ∈ [1,𝑘𝑘]𝑛𝑛

𝑗𝑗=0

�

trong đó:

𝑤𝑤𝑡𝑡𝑡𝑡: bộ tham số mô hình huấn luyện tổng hợp

𝑘𝑘: số lượng tham số trong bộ tham số mô hình huấn luyện tổng hợp

𝑡𝑡: số lượng bộ tham số của máy con cần được tổng hợp

𝑤𝑤𝑗𝑗𝑖𝑖: tham số tại vị trí 𝑖𝑖 thuộc bộ tham số của máy con 𝑗𝑗.

2.8.3. Thuật toán

1. procedure: sumWeight_FL()

2. Input: 𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛 ← mảng hai chiều có n bộ tham số mô hình huấn luyện con, mỗi bộ tham

số mô hình huấn luyện con có k tham số

3. 𝑖𝑖𝑜𝑜𝑓𝑓 𝑖𝑖 = 0 → 𝑘𝑘:

4. 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡 = 0

5. 𝑖𝑖𝑜𝑜𝑓𝑓 𝑗𝑗 = 0 → 𝑡𝑡:

6. 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡 = 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡 + 𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛[𝑗𝑗][𝑖𝑖]

7. 𝑤𝑤𝑡𝑡𝑡𝑡[𝑖𝑖] = 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡/𝑡𝑡

8. return 𝑤𝑤𝑡𝑡𝑡𝑡 ← mảng bộ tham số tổng hợp có k tham số

3. Đề xuất thuật toán cải tiến về bộ nén tham số mô hình huấn luyện

Việc truyền tải bộ tham số mô hình huấn luyện qua lại giữa các máy con với máy chủ

xảy ra liên tục trong quá trình học, tạo sức ép lớn lên mạng kết nối cũng như ảnh hưởng tới

thời gian đợi của máy chủ trong pha báo cáo. Nếu mô hình huấn luyện lớn, kéo theo dung

lượng bộ tham số cũng lớn theo, có thể lên tới vài trăm MB. Điều này gây khó dễ cho các

máy con có đường truyền mạng kém, không ổn định. Đồng thời, cũng gây khó khăn cho máy

chủ khi phải tiếp nhận và xử lí bộ tham số dung lượng lớn của nhiều máy con cùng lúc.

Tạp chí Khoa học Trường ĐHSP TPHCM Nguyễn Thị Hường và tgk

473

Vì vậy, chúng tôi tìm cách giảm dung lượng của bộ tham số mô hình huấn luyện, giúp

tăng tốc độ cũng như giảm áp lực về sự truyền tải tham số qua mạng.

Ý tưởng cho việc giảm dung lượng bộ tham số mô hình huấn luyện là bỏ đi ngẫu nhiên

một tập con của các tham số trong bộ tham số đó theo một ngưỡng tối thiểu cho trước, rồi

mới gửi bộ tham số đó lên máy chủ. Khi máy chủ thực hiện tổng hợp các bộ tham số, nếu

tham số nào rỗng sẽ bỏ qua, chỉ lấy trung bình cộng những tham số khác rỗng.

Cơ sở cho ý tưởng nén này là về mặt lí thuyết, nếu các máy con có lượng dữ liệu đủ

lớn và mô hình huấn luyện phù hợp thì mỗi mô hình huấn luyện của từng máy con đều hướng

tới cùng một mô hình huấn luyện chung tốt, bộ tham số sẽ gần giống nhau. Nên khi ta ngẫu

nhiên bỏ đi tham số trong bộ tham số của máy con này thì theo cách ngẫu nhiên sẽ có máy

con khác không bỏ đi tham số đó. Như vậy, các tham số sẽ được xen kẽ bổ sung cho nhau ở

các máy con. Ý tưởng này sẽ không ảnh hưởng quá nhiều tới kết quả chung.

Thuật toán nén bộ tham số

1. procedure: scaleWeight_FL()

2. Input: 𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛 ← mảng bộ tham số ở máy con có k tham số

3. 𝑑𝑑𝑑𝑑𝑡𝑡𝑡𝑡𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡(𝑥𝑥) ← hàm tính dung lượng của một biến 𝑥𝑥

4. Xáo trộn ngẫu nhiên phần tử trong 𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛

5. 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡𝑑𝑑𝑑𝑑𝑡𝑡𝑡𝑡𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡 = 0

6. 𝑖𝑖𝑜𝑜𝑓𝑓 𝑖𝑖 = 0 → 𝑘𝑘:

7. 𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛[𝑖𝑖] = ∅

8. 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡𝑑𝑑𝑑𝑑𝑡𝑡𝑡𝑡𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡 = 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡𝑑𝑑𝑑𝑑𝑡𝑡𝑡𝑡𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡 + 𝑑𝑑𝑑𝑑𝑡𝑡𝑡𝑡𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡(𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛[𝑖𝑖])

9. 𝑖𝑖𝑖𝑖 𝑡𝑡𝑐𝑐𝑛𝑛𝑡𝑡𝑡𝑡𝑡𝑡𝑛𝑛𝑡𝑡𝑡𝑡𝑡𝑡𝑐𝑐𝑛𝑛𝑡𝑡

𝑡𝑡𝑡𝑡𝑛𝑛𝑡𝑡𝑡𝑡𝑡𝑡𝑐𝑐𝑛𝑛𝑡𝑡(𝑤𝑤𝑐𝑐𝑐𝑐𝑐𝑐) > ∅:

10. break

Thuật toán tổng hợp bộ tham số

1. procedure: sumScaleWeight_FL()

2. Input: 𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛 ← mảng hai chiều có n bộ tham số mô hình huấn luyện con, mỗi bộ

tham số mô hình huấn luyện con có k tham số

3. 𝑖𝑖𝑜𝑜𝑓𝑓 𝑖𝑖 = 0 → 𝑘𝑘:

4. 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡 = 0

5. 𝑠𝑠𝑜𝑜𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡 = 0

6. 𝑖𝑖𝑜𝑜𝑓𝑓 𝑗𝑗 = 0 → 𝑡𝑡:

7. 𝑖𝑖𝑖𝑖 𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛[𝑗𝑗][𝑖𝑖] ≠ ∅:

8. 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡 = 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡 + 𝑤𝑤𝑐𝑐𝑐𝑐𝑛𝑛[𝑗𝑗][𝑖𝑖]

9. 𝑠𝑠𝑜𝑜𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡+= 1

10. 𝑖𝑖𝑖𝑖 𝑠𝑠𝑜𝑜𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡 ≠ ∅:

11. 𝑤𝑤𝑡𝑡𝑡𝑡[𝑖𝑖] = 𝑡𝑡𝑜𝑜𝑡𝑡𝑡𝑡/𝑠𝑠𝑜𝑜𝑑𝑑𝑑𝑑𝑜𝑜𝑡𝑡𝑡𝑡

12. return 𝑤𝑤𝑡𝑡𝑡𝑡 ← mảng bộ tham số tổng hợp có k tham số

Tạp chí Khoa học Trường ĐHSP TPHCM Tập 18, Số 3 (2021): 463-476

474

4. Kết quả

Để đánh giá được phương pháp, chúng tôi dùng tập dữ liệu huấn luyện CIFAR10 gồm

60.000 hình được chia làm 2 tập, 50.000 hình là tập huấn luyện và 10.000 hình là tập kiểm

tra. Mỗi hình có kích thước 32 × 32 là hình màu gồm có 10 nhãn là: máy bay, xe hơi, chim,

mèo, nai, chó, ếch, ngựa, tàu và xe tải.

Để giải quyết bài toán phân loại ảnh, chúng tôi sử dụng mạng nơ-ron tích chập CNN

và mô hình học liên kết rút gọn. Chúng tôi thực hiện khảo sát số lượng máy con từ 1 đến

100, với số lượng máy con bằng 1 thì được xem là mô hình học cục bộ. Các yếu tố còn lại:

- Độ lớn batch bằng 100;

- Dữ liệu được chia đều ngẫu nhiên cho từng máy con. Số lượng dữ liệu ở máy con bằng

số lượng tập huấn luyện chia số lượng máy con.

Kết quả sử dụng nén bộ tham số:

Hình 8. Minh họa 1 vòng trong Học liên kết cải tiến

Kết quả không nén bộ tham số

Tạp chí Khoa học Trường ĐHSP TPHCM Nguyễn Thị Hường và tgk

475

Hình 9. Minh họa vòng 1 trong Học liên kết gốc

Nén bộ tham số mô hình huấn luyện vừa dễ dàng hiểu về mặt lí thuyết và dễ dàng triển

khai về mặt thực tế, đem lại tốc độ hội tụ và độ chính xác không thua kém so với không nén

bộ tham số.

Về mặt hiệu quả, mô hình học liên kết cho tốc độ học nhanh hơn và có độ chính xác

tổng quát cao hơn khi ta hiểu và cài đặt tham số hợp lí với từng bài toán.

Về mặt ứng dụng, mô hình học liên kết có thể phát triển thành hệ thống trí tuệ nhân

tạo cho các tập đoàn, công ti lớn, để tăng tốc độ học khai thác tối đa tài nguyên của

máy tính.

Về mặt bảo mật dữ liệu, đây là một phương pháp cực kì hữu ích cho bài toán tạo một

mô hình học cần bảo mật dữ liệu.

Tuyên bố về quyền lợi: Các tác giả xác nhận hoàn toàn không có xung đột về quyền lợi.

Lời cảm ơn: Nghiên cứu được tài trợ bởi Đại học Quốc gia Thành phố Hồ Chí Minh

(ĐHQG-HCM) trong dự án NCM2019-18-01.

Tạp chí Khoa học Trường ĐHSP TPHCM Tập 18, Số 3 (2021): 463-476

476

TÀI LIỆU THAM KHẢO

Cenk Bircanoğlu, & Nafiz Arıca (2018). A comparison of activation functions in artificial neural

networks, Bahcesehir Universitesi, Istanbul, TR.

Fanglin Li, Bin Wu, Liutong Xu, Chuan Shi, & Jing Shi (2014). A fast distributed stochastic Gradient

Descent Algorithm for Matrix Factorization, Beijing Key Lab of Intelligent

Telecommunication Software and Multimedia.

Jakub Konecny, H. Brendan McMahan, & Daniel Ramage (2016). Federated Optimization:

Distributed Machine Learning for On-Device Intelligence, University of Edinburgh.

McMahan, Daniel Ramage (2017). Federated Learning: Collaborative Machine Learning without

Centralized Training Data.

Brendan McMahan, Eider Moore, Daniel Ramage, Seth Hampson, Blaise Aguera y Arcas (2017).

Communication-efficient learning of deep networks from decentralized data, Google, Inc.,

651 N 34th St., Seattle, WA 98103 USA.

Saad Albawi, Tareq Abed Mohammed, & Saad Al-Zawi (2017). Understanding of a convolutional

neural network, Department of Computer Engineering, Istanbul Kemerburgaz University,

Istanbul, Turkey.

Siddharth Sharma, & Simone Sharma (2020). Activation functions in neural networks, Dept. of

Computer Science and Engineering, Global Institute of Technology, Jaipur.

DATA PRIVACY-PRESERVING VIA IMPROVED FEDERATED LEARNING MODEL

Nguyen Thi Huong1*, Bui Huy Toan2, Le Tan Phong2, Nguyen Dinh Thuc2

1Smartnet HCMC, Vietnam

2University of Science, Vietnam National University Ho Chi Minh City, Vietnam

*Corresponding author: Nguyen Thi Huong – Email: nguyenhuongk07@gmail.com

Received: March 02, 2021; Revised: March 18, 2021; Accepted: March 20, 2021

ABSTRACT

Data modeling is an important problem in data analysis. Machine learning is the most popular

method to solve this modeling problem. All most of machine learning schemes are local learning

schemes in which the training dataset is stored at a server, therefore it can’t take advantage of the

diversity of data shared from multiple sources. As a result, the generalization of the obtained model

is limited. The federated learning is a learning from multi-source of data so it has many advantages

compared to other methods. Federated learning model applies to a variety of data types and machine

learning algorithms. Besides accuracy, this model also ensures privacy for the training data set. This

paper proposes an improvement of the federated learning model to ensure privacy protection based

on an federated-learning model. The experimental results show the feasibility which can be applied

to problems using machine learning in practice and also open up challenges to improve research

and innovation.

Keywords: differential privacy; federated learning; privacy-preserving data analysis; privacy-

preserving with federated learning

File đính kèm:

dam_bao_tinh_rieng_tu_du_lieu_voi_hoc_lien_ket_cai_tien.pdf

dam_bao_tinh_rieng_tu_du_lieu_voi_hoc_lien_ket_cai_tien.pdf