Bài giảng Khai phá dữ liệu - Hà Quang Thụy

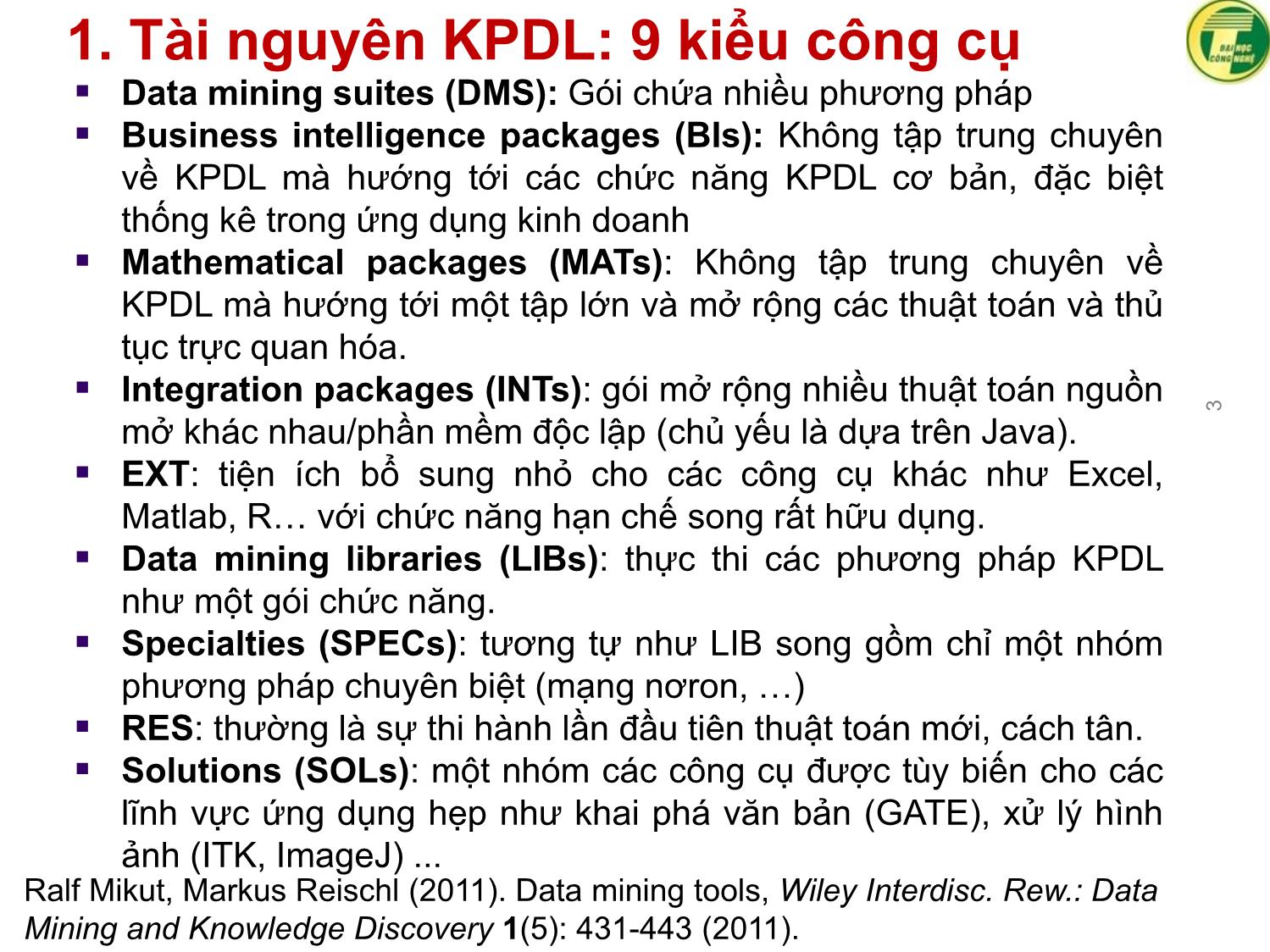

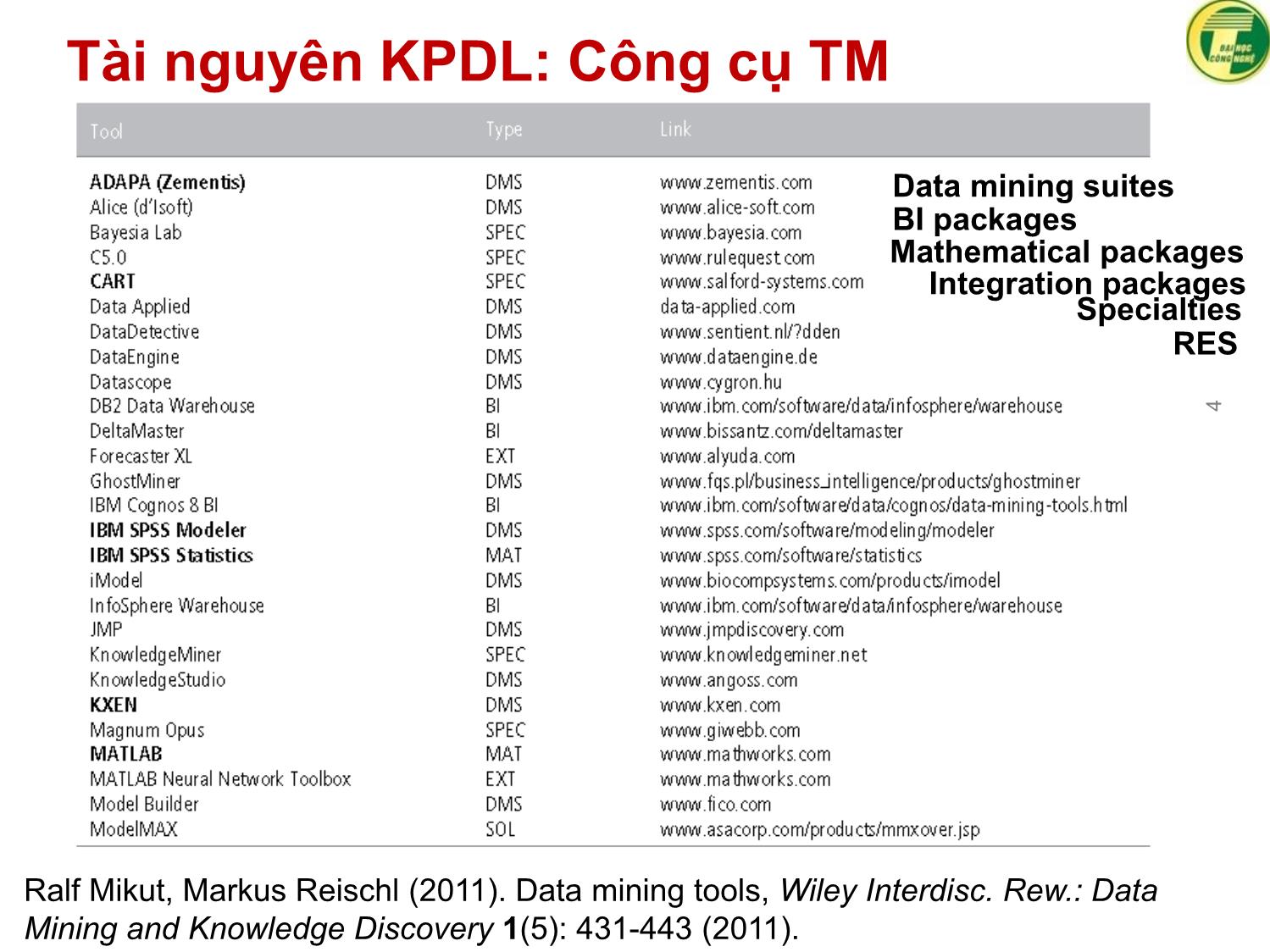

1. Tài nguyên KPDL: 9 kiểu công cụ

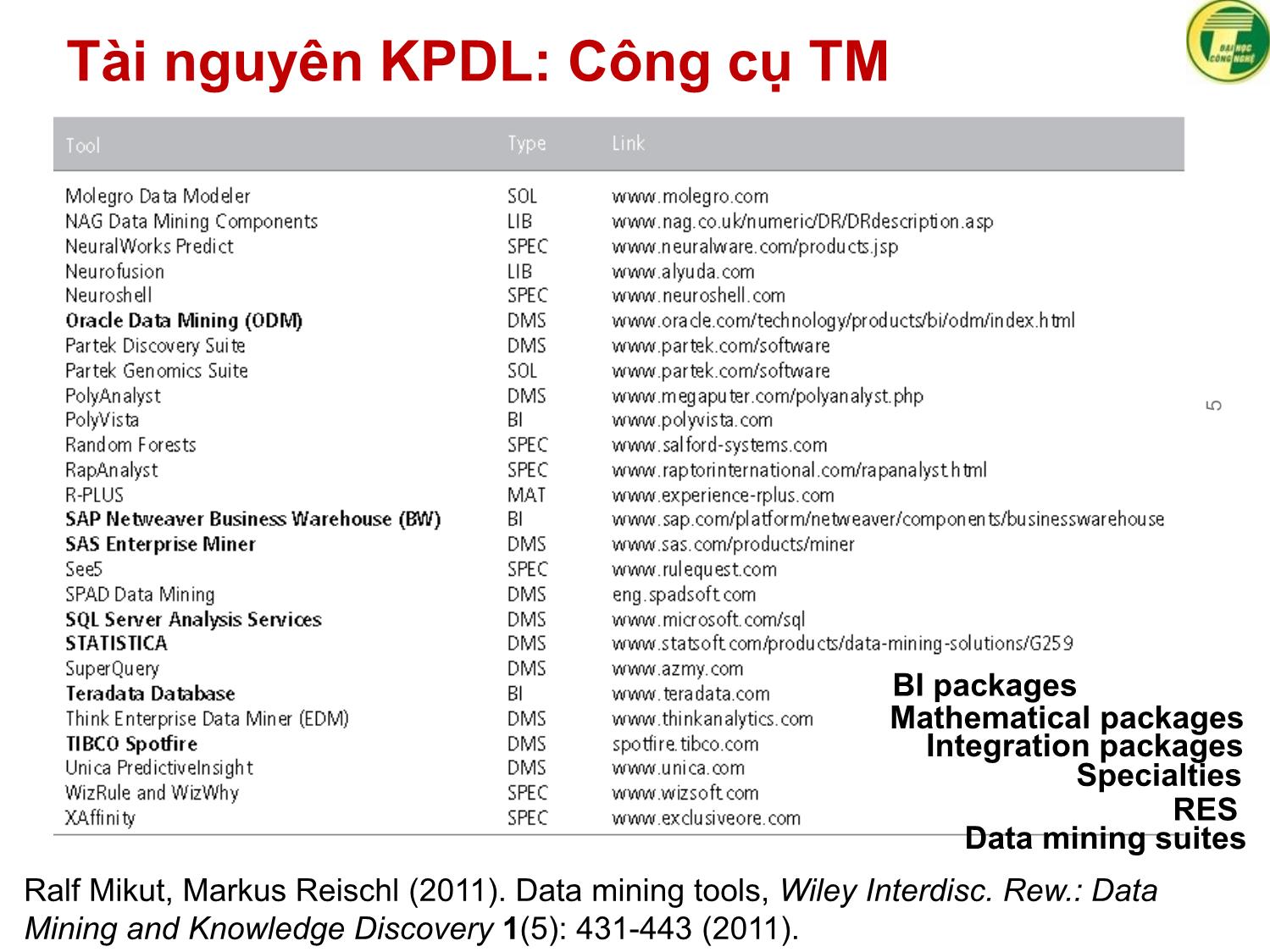

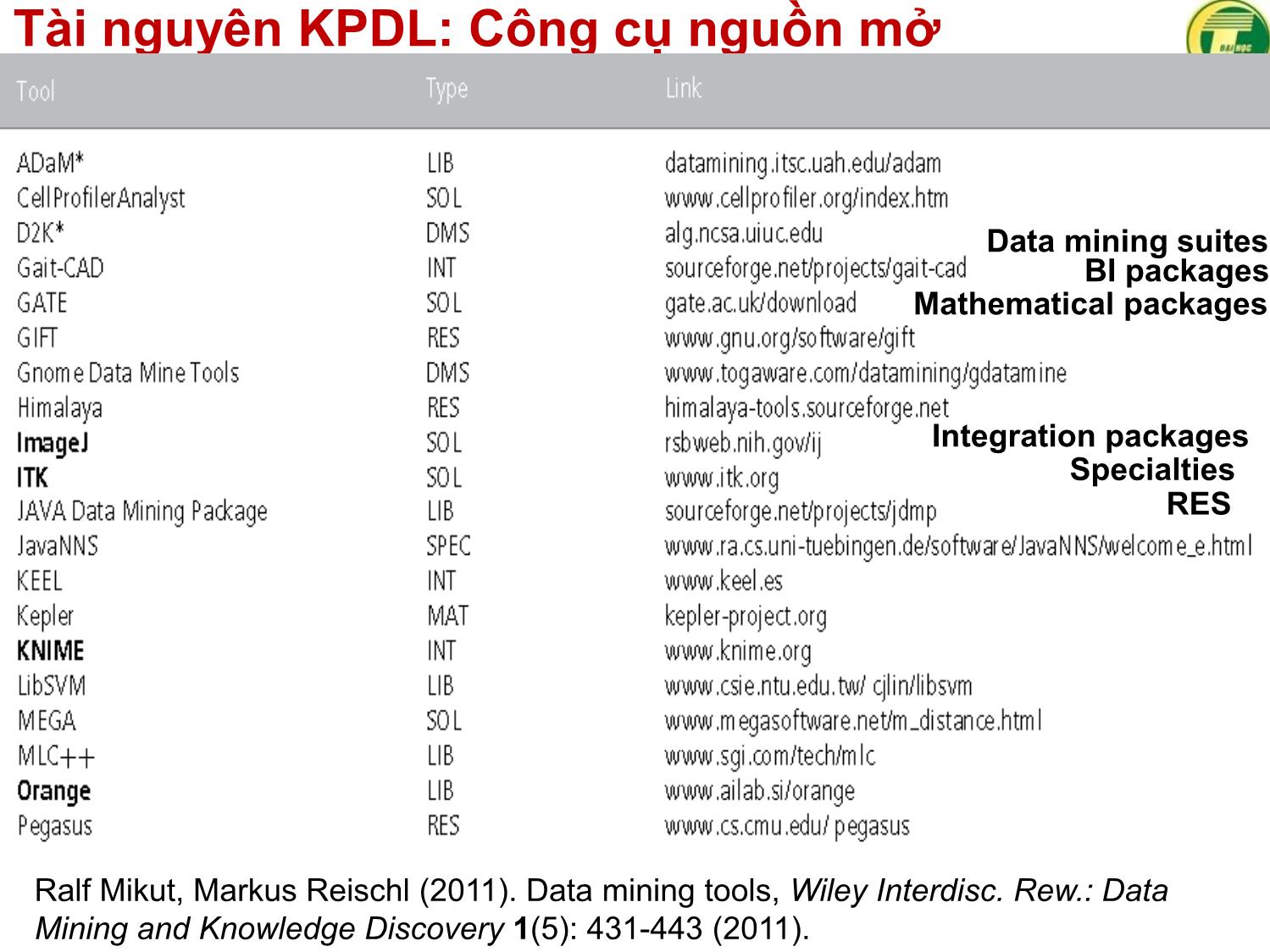

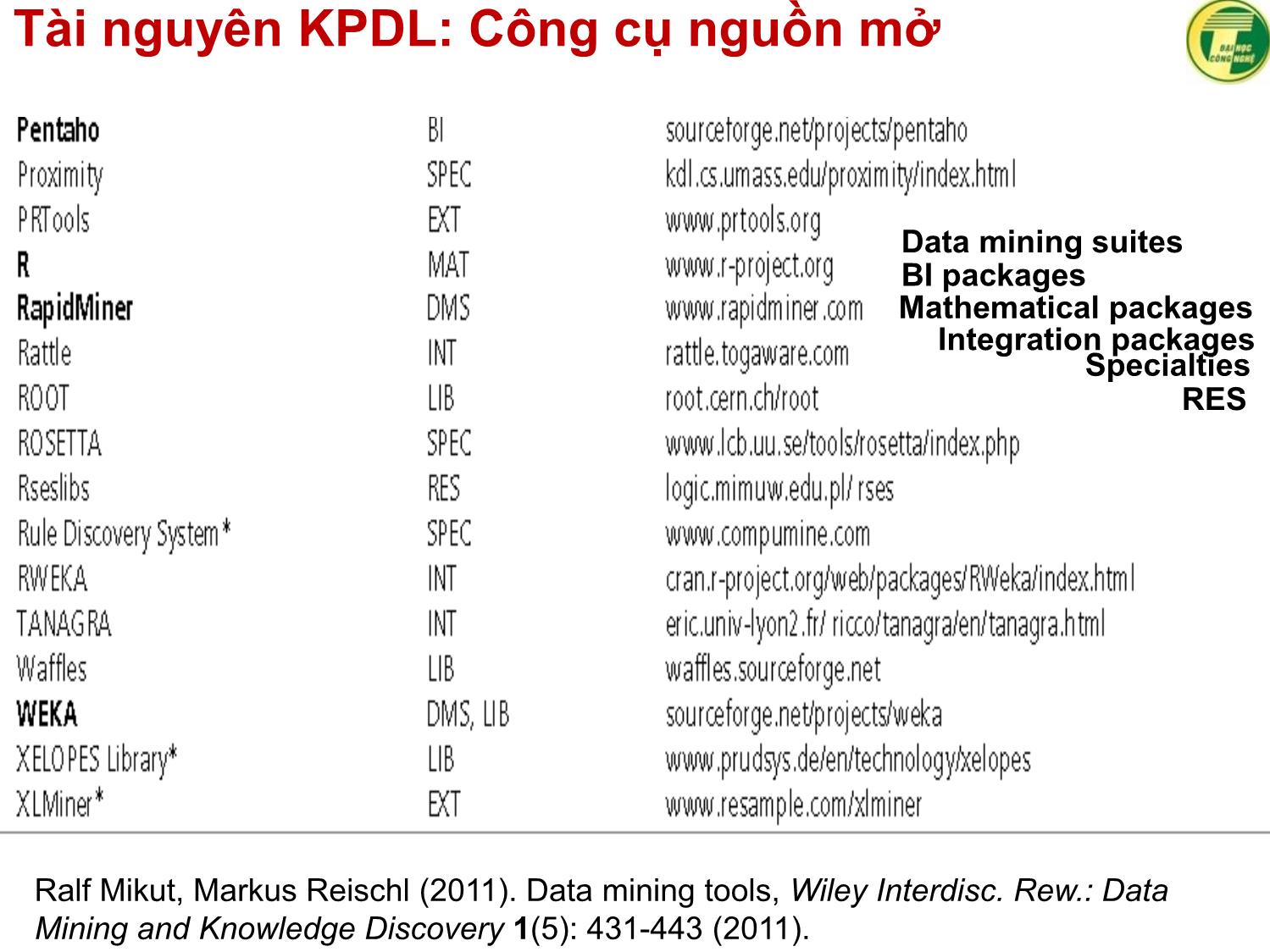

▪ Data mining suites (DMS): Gói chứa nhiều phương pháp

▪ Business intelligence packages (BIs): Không tập trung chuyên

về KPDL mà hướng tới các chức năng KPDL cơ bản, đặc biệt

thống kê trong ứng dụng kinh doanh

▪ Mathematical packages (MATs): Không tập trung chuyên về

KPDL mà hướng tới một tập lớn và mở rộng các thuật toán và thủ

tục trực quan hóa.

▪ Integration packages (INTs): gói mở rộng nhiều thuật toán nguồn

mở khác nhau/phần mềm độc lập (chủ yếu là dựa trên Java).

▪ EXT: tiện ích bổ sung nhỏ cho các công cụ khác như Excel,

Matlab, R với chức năng hạn chế song rất hữu dụng.

▪ Data mining libraries (LIBs): thực thi các phương pháp KPDL

như một gói chức năng.

▪ Specialties (SPECs): tương tự như LIB song gồm chỉ một nhóm

phương pháp chuyên biệt (mạng nơron, )

▪ RES: thường là sự thi hành lần đầu tiên thuật toán mới, cách tân.

▪ Solutions (SOLs): một nhóm các công cụ được tùy biến cho các

lĩnh vực ứng dụng hẹp như khai phá văn bản (GATE), xử lý hình

ảnh (ITK, ImageJ) .

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Trang 9

Trang 10

Tải về để xem bản đầy đủ

Tóm tắt nội dung tài liệu: Bài giảng Khai phá dữ liệu - Hà Quang Thụy

trong lấy mẫu

Gibbs

▪ Sử dụng mô hình Multi-generated Pólya Urn cho cannot-links

78

Một mô hình đề xuất [ACIIDS2018]

Quang-Thuy Ha,

Thi-Cham Nguyen et al.

⚫ Giải thích

▪ Dựa trên AMC

▪ Thiên vị mức “miền dữ liệu”: chỉ lấy miền dữ liệu gần S*

▪ Định nghĩa độ gần nhau: mức chủ đề và mức miền

▪ Mức miền: tập từ vựng, tập từ tốp đầu, lượng chủ đề gần nhau

▪ Mức chủ đề: độ đo cosine cho hai túi từ có trọng số

79

Áp dụng phân lớp đa nhãn văn bản

Kiểm thử

một mẫu

cho kỳ vọng

giả thuyết

quần thể

với phương

sai chưa

biết: kết

quả tăng

thực sự so

với AMC

80

WordNet và mô hình chủ đề suốt đời

⚫ WordNet chung: Thành phần kho tri thức

[Chen16]

▪ Đề cập cơ sở tri thức KB khởi đầu: | WordNet

▪ Tiếp theo: chỉ đề cập tới KB khởi đầu

⚫ Vấn đề

▪ ? Sử dụng WordNet: tính đa nghĩa của từ, đồng nghĩa/nghịch

nghĩa có ngư cảnh các từ.

▪ Đồng nghĩa: mustlinks, nghịch nghĩa: Cannotlinks

▪ Vấn đề: “ngữ cảnh” đồng nghĩa/nghịch nghĩa

▪ Wordnet chung hay WordNet tự xây dựng ?

▪ Wordnet chung: sẵn có VietWordNet từ KC.01.02/06-10

▪ Wordnet tự xây dựng: liên quan tới từng miền

81

Học sâu suốt đời: một chủ đề nghiên cứu

⚫ Các chủ đề nghiên cứu về học suốt đời

▪ Học suốt đời phân lớp và hồi quy (Lifelong Learning for

Classification and Regression)

▪ Học tăng cường suốt đời (Lifelong Reinforcement Learning)

▪ Học suốt đời với chuyển giao tri thức mức cao (Few-Shot

Transfer in Lifelong Learning). David Isele.

trier.de/pers/hd/i/Isele:David . ACIIDS 2018?

▪ Học sâu suốt đời (Deep Lifelong Learning)

▪ Học suốt đời mô hình người dùng và cung cấp đám đông

(Lifelong Learning for User Modeling and Crowdsourcing)

▪ Học suốt đời người máy (Lifelong Robot Learning)

▪ Học suốt đời thông tin cấu trúc (Lifelong Learning of

Structured Information)

82

Học sâu: Nhận định của François Chollet

⚫ An Interview with François Chollet

▪ François Chollet, ít thông tin cá nhân

https://research.google.com/pubs/105096.html

https://www.linkedin.com/in/fchollet https://www.kaggle.com/rankings

Công bố không nhiều

trier.de/pers/hd/c/Chollet:Fran=ccedil=ois

▪ Hạng Kaggle cao nhất đạt được: 17th toàn cầu

▪ AI và học sâu của Google

▪ Tác giả: (i) Keras: khung học sâu Python hàng

đầu nguồn mở: Google Scholar Cited 1060, (ii)

Sách "Deep Learning with Python“

▪ https://www.datacamp.com/community/blog/int

erview-francois-chollet

▪ https://www.datacamp.com/community/tutorials

/deep-learning-python

▪ [Chollet18] François Chollet. Deep Learning

with Python. Manning, 2018

83

Học sâu: Hạn chế [Chollet18]

⚫ Giới thiệu

▪ Hạn chế của học sâu

▪ Học sâu suốt đời: Một chủ đề nghiên cứu thời sự

⚫ Học sâu và hạn chế

▪ Học sâu “vô hạn” ứng dụng

▪ nhiều ứng dụng ngoài tầm học sâu dù có rất nhiều ví dụ mẫu

▪ X={mô tả sản phẩm phần mềm do một người quản lý viết}

▪ Y={mã nguồn đáp ứng mô tả do một đội viết}

▪ Cho 105 (106) cặp (x, y) X Y. Không thể sinh một mô hình học

sâu ánh xạ X → Y

▪ Giải thích: học xâu = chuỗi các phép biến đổi hình học đơn giản

và liên tục: X → Y (hai không gian vector) ngầm định dãy biến

đổi liên tục từ X sang Y.

▪ Một mô hình học sâu là một chương trình song hầu hết chương

trình không thể biểu diễn bằng mô hình học sâu

▪ Chồng lấp mô hình chỉ giảm thiểu mà không giải quyết

https://blog.keras.io/the-limitations-of-deep-learning.html

84

Hạn chế học sâu: ví dụ1

“Cậu bé đang cầm cây gậy phân loại ảnh gấu trúc thành vượn

bóng chày”

⚫ Rủi ro nhân cách hóa mô hình học máy

▪ anthropomorphizing

▪ Nhận dạng ảnh: chỉ một thay đổi nhỏ cho kết quả khác biệt

▪ Giải thích: mô hình học sâu không hiểu gì về đầu vào như con người

▪ Con người hiểu biết về hình ảnh, âm thanh, ngôn ngữ

[Chollet18] François Chollet. Deep Learning with Python. Manning, 2018

85

Hạn chế học sâu: Ảnh mờ trong gương

Trải nghiệm Tóm tắt khái Dữ liệu có Mô hình

Thế giới thực con người niệm vào tâm nhãn minh học máy

trí người hoạ khái niệm

Không phải lúc nào Không khớp với mô Khớp với dữ

hình tâm trí người

cũng chuyển tốt tới thế liệu học

giới thực dẫn xuất

⚫ Lưu ý chuyên gia học máy

▪ Tránh rơi vào bẫy miền tin “mạng nơ-ron hiểu được bài toán cần làm”

▪ Thực hiện nhiệm vụ hẹp hơn so với mong muốn con người

▪ Dữ liệu khác ví dụ học: mạng nơ-ron phá vỡ một cách vô lý

[Chollet18] François Chollet. Deep Learning with Python. Manning, 2018

86

Học sâu khác biệt với người học

⚫ Khái quát hóa cục bộ khái quát hóa tới cực

▪ Học sâu: biến dạng hình học đơn giản từ đầu vào tới đầu ra.

Khái quát hóa cục bộ (local generalization)

▪ “Con” người học: qua trải nghiệm bản thân thay vì được trình

diễn qua ví dụ học

▪ Năng lực cao > ánh xạ kích thích trực tiếp để đáp ứng trực tiếp

▪ Duy trì các mô hình phức tạp, tóm tắt các mô hình cho tình

huống hiện thời, dùng mô hình cho tương lai

▪ Khái quát hóa “cận biên” (extreme generalization)

[Chollet18] François Chollet. Deep Learning with Python. Manning, 2018

87

Tương lai học sâu: suy đoán [Chollet18]

⚫ Mô hình như là một chương trình máy tính

▪ Từ khái quát hóa cục bộ tới khái quát hóa cận biên (lập luận

và trừu tượng hóa)

▪ Hiện tại: thành phần học của hệ thống chỉ xảy ra ở mô đun

chuyên dụng. Tương lai: hệ thống học đầy đủ, không có sự

tham gia của con người

algorithmic primitives

geometric primitives

[Chollet18] François Chollet. Deep Learning with Python. Manning, 2018

88

Truyền ngược, phân biệt và học tự động

⚫ Vượt qua tầng lan truyền ngược, sự phân biệt

▪ “Chương trình” mô hình vẫn sử dụng chương trình con hình học

(phân biệt) song toàn bộ chương trình là không phân biệt

▪ Lan truyền ngược là cách thức không nên chọn

▪ Không phân biệt toàn bộ song phân biệt cục bộ

⚫ Học máy tự động

▪ Tương lai: học kiến trúc mô hình

▪ Tìm kiếm kiến trúc phù hợp dựa trên học tăng cường và học di

truyền

▪ Học kiến trúc mô hình đồng thời với trọng số mô hình

▪ Thay thế công việc của kỹ sư học máy → kỹ sư học máy hướng

mô hình tới mục tiêu kinh doanh, mô hình tác động tới hệ sinh

thái kỹ thuật số

[Chollet18] François Chollet. Deep Learning with Python. Manning, 2018

89

Học sâu suốt đời: tái sử dụng mô-đun

▪ Chương trình con thuật toán (Algorithmic subroutine): tri thức

mức miền, được tổ chức vào thư viện

▪ Chương trình con hình học (Geometric subroutine): tri thức mức

dữ liệu cụ thể liên quan tới thuật toán học sâu

[Chollet18] François Chollet. Deep Learning with Python. Manning, 2018

90

Học sâu suốt đời

⚫ Nhận diện thực thể

▪ Lei Shu, Hu Xu, Bing Liu. Lifelong Learning CRF for Supervised Aspect

Extraction. ACL (2) 2017:148-154. Học suốt đời nhận diện thực thể

▪ Lei Shu, Bing Liu, Hu Xu, Annice Kim. Lifelong-RL: Lifelong Relaxation

Labeling for Separating Entities and Aspects in Opinion Targets.

EMNLP 2016: 225-235. Học suốt đời nhận diện thực thể

▪ Chen Tessler, Shahar Givony, Tom Zahavy, Daniel J. Mankowitz, Shie

Mannor. A Deep Hierarchical Approach to Lifelong Learning in

Minecraft. AAAI 2017: 1553-1561. Học sâu dữ liệu ảnh

⚫ Học sâu suốt đời phân lớp đa nhãn

▪ Lei Shu, Hu Xu, Bing Liu. DOC: Deep Open Classification of Text

Documents. EMNLP 2017: 2911-2916. Học sâu

▪ Geli Fei, Shuai Wang, Bing Liu. Learning Cumulatively to Become More

Knowledgeable. KDD 2016: 1565-1574. Phân lớp sâu suốt đời = học

tích lũy + học sâu (trên)

▪ Quang-Thuy Ha, Thi-Ngan Pham, Van-Quang Nguyen, Thi-Cham

Nguyen, Thi-Hong Vuong, Minh-Tuoi Tran and Tri-Thanh Nguyen. A

New Lifelong Topic Modeling Method and Its Application to Vietnamese

Text Multi-label Classification. ACIIDS 2018 (in press). Phân lớp đa

nhãn dựa trên mô hình chủ đề suốt đời.

91

Một dự án học sâu suốt đời

⚫ Giới thiệu

▪ Do Eric Eaton chủ trì, được AFRL và DARPA tài trợ

▪ https://www.grasp.upenn.edu/projects/lifelong-deep-

learning

▪ Xem [Isele17]

92

Học sâu suốt đời

⚫ Một vài tham khảo khác

▪ David Isele. Thesis Proposal: Representations for Continuous Learning.

Proceedings of the Thirty-First AAAI Conference on Artificial

Intelligence (AAAI-17).

https://www.grasp.upenn.edu/people/david-isele

https://www.grasp.upenn.edu/labs/lifelong-machine-learning

▪ Simon Stiebellehner, Jun Wang, Shuai Yuan. Learning Continuous

User Representations through Hybrid Filtering with doc2vec.

arXiv:1801.00215.

▪ Andrei A. Rusu, Neil C. Rabinowitz, Guillaume Desjardins, Hubert

Soyer, James Kirkpatrick, Koray Kavukcuoglu, Razvan Pascanu, Raia

Hadsell. Progressive Neural Networks. CoRR abs/1606.04671, 2016

▪ Irina Higgins, Arka Pal, Andrei A. Rusu, Loïc Matthey, Christopher

Burgess, Alexander Pritzel, Matthew Botvinick, Charles Blundell,

Alexander Lerchner. DARLA: Improving Zero-Shot Transfer in

Reinforcement Learning. ICML 2017: 1480-1490

▪ James Kirkpatrick et al. Overcoming catastrophic forgetting in neural

networks. CoRR abs/1612.00796, 2016.

▪ v.v.

93

GIỚI THIỆU VỀ HỌC MÁY THẾ GIỚI MỞ

94

Tài liệu nghiên cứu

⚫ [Chen18] Zhiyuan Chen, Bing Liu. Lifelong

Machine Learning (2nd edittion). Morgan &

Claypool, 2018

▪ CHAPTER 5. Open-World Learning

▪ [Bendale15] Abhijit Bendale and Terrance E Boult. Towards open world

recognition. IEEE Conference on Computer Vision and Pattern

Recognition, pages 1893–1902, 2015.

▪ [Fei16] Geli Fei and Bing Liu. Breaking the closed world assumption in

text classification. NAACL-HLT, pages 506–514, 2016.

▪ [Fei16a] Geli Fei, Shuai Wang, Bing Liu. Learning Cumulatively to

Become More Knowledgeable. KDD 2016: 1565-1574.

▪ [Shu17] Lei Shu, Hu Xu, Bing Liu. DOC: Deep Open Classification of

Text Documents. EMNLP 2017: 2911-2916.

▪ Lei Shu, Hu Xu, Bing Liu. Unseen Class Discovery in Open-world

Classification. CoRR abs/1801.05609, 2018

▪ CHAPTER 8. Continuous Knowledge Learning in Chatbots

▪ [Mazumder18] Sahisnu Mazumder, Nianzu Ma, and Bing Liu. Towards

a continuous knowledge learning engine for chatbots.

ArXiv:1802.06024, 2018

95

Ví dụ minh họa 1: Người máy chào hỏi

⚫ Người máy chào đón khách hàng ở cửa ra-vào

▪ Với mỗi khách hàng quen: Có ảnh, tên khách hàng, thông tin

khác và mô hình đoán nhận khách hàng từ ảnh

▪ Một khách hàng tới cửa ra –vào. Người máy chụp ảnh, sử dụng

mô hình đoán nhận khách hàng để biết tên khách hàng.

⚫ Tiếp cận học máy thế giới đóng

▪ Số lớp = số lượng khách hàng quen + 01 “lớp chưa biết”

▪ Khách quen: phát hiện, chào hỏi theo tên

▪ Khách lạ: phân vào lớp chưa biết và đợi người quản lý nạp mô

hình phân lớp mới.

⚫ Tiếp cận học máy thế giới đóng

▪ Số lớp = số lượng khách hàng quen + k “lớp chưa biết”

▪ Khách quen: phát hiện lớp, chào hỏi theo tên

▪ Khách lạ: bổ sung dữ liệu về khách như chụp thêm ảnh nhận

diện, đàm thoại với khách hàng hoặc người quản lý để biết tên

và các thông tin khác về khách hàng. Chào hỏi theo tên. Xây

dựng mô hình đoán nhận khách hàng theo ảnh.

96

Ví dụ minh họa 2: Chatbot với chủ đề mới

⚫ Đàm thoạichatbot

▪ Chatbot đã nhận biết được một số chủ đề cho trước theo mô

hình phân lớp từ ví dụ học liên quan tới mỗi chủ đề

▪ Khởi động một đàm thoại mới: Sử dụng các mô hình phân lớp

để nhận diện chủ đề của đàm thoại hiện thời

⚫ Tiếp cận thế giới đóng

▪ Người đàm thoại nêu câu đàm thoại, dùng các mô hình phân

lớp phát hiện chủ đề người đàm thoại nêu ra.

▪ Sử dụng cơ sở tri thức cho chủ đề chưa biết: suy luận tuy nhiên

không tự nhiên

⚫ Tiếp cận thế giới mở

▪ Số lớp = số chủ đề đã biết + k lớp “khác đi”

▪ Câu đàm thoại thuộc chủ đề: tiếp tục trợ giúp

▪ Câu đàm thoại không thuộc chủ đề đã biết. Sử dụng Cơ sở tri

thức, đàm thoại người dùng để thêm tri thức dữ kiện.

▪ Xây dựng mô hình phân lớp theo các chủ đề liên quan với đàm

thoại bổ sung.

97

Ví dụ minh họa 3: Xe tự lái trên đường

⚫ Xe tự lái

▪ Muôn màu “vật” có thể gặp trên đường

▪ Có mô hình liên quan tới các kiểu đối tượng “đã biết”

▪ Xuất hiện không ngừng các đối tượng “chưa biết”

⚫ Chỉ có thể tiếp cận thế giới mở

▪ Bài toán rất phức tạp

▪ Ghi nhận dữ liệu đối tượng chưa biết và tương tác để có thêm

thông tin về đối tượng chưa biết

▪ Tương tác: (i) người giám sát, (2) khách hàng, (3) đa tác tử: kết

nối với các xe đang vận hành “láng giềng” bổ sung tri thức về

đối tượng chưa biết

⚫ Qua ba ví dụ

▪ Nhận ra một “cái mới chưa biết” nào đõ xuất hiện

▪ Tự động học để hiểu về “cái mới chưa biết” đó

98

Học thế giới mở

⚫ Định nghĩa

N

1) Bộ học có một mô hình phân lớp đa lớp F ={f1, f2,..., fN} từ N

N

tập dữ liệu lớp quá khứ D = {D1, D2, , DN} với các nhãn lớp

N

tương ứng Y = {l1, l2, , lN}. thể hiện mới x, FN hoặc gán

N

nhãn li Y hoặc từ chối và đưa x vào tập chưa biết R.

2) Hệ thống/người sử dụng xác định các lớp chưa biết ẩn C trong

R và thu thập dữ liệu học cho các lớp chưa biết

3) Giả sử có k lớp mới đã đủ dữ liệu học, bộ học học gia tăng k

lớp mới theo dữ liệu học. Bộ học cập nhật là (FN+k, DN+k, YN+k).

⚫ Học thế giới mở là một dạng học suốt đời

▪ Bài toán TN+1: xây dựng bộ phân lớp mở đa lớp dựa trên các lớp

đã biết và các lớp mới

▪ Cơ sở tri thức: mọi mô hình thuộc FN+k và mọi dữ liệu thuộc

DN+k.

▪ 3) học gia tăng truyền thống (không từ chối thể hiện lớp chưa

biết) dù có bổ sung lớp mới gia tăng mà không cần học lại toàn

bộ mô hình

99

Học không gian tương tự theo tâm [Fei16]

⚫ Tư tưởng

▪ Học khái niệm mới của con người thông qua các khái niệm

tương tự đã biết

▪ Đã biết {“phim”, “đồ nội thất”, “bóng đá”} cần học khái niệm mới

chưa biết “bóng rổ”. “Bóng rổ” tương tự “bóng đá” và rất khác

biệt “phim” và “đồ nội thất”

▪ Hai bước (1) tìm kiếm tập SC các lớp đã biết tương tự lớp mới

chưa biết lN+1, (2) học phân biệt tách lớp mới chưa biết lN+1 với

các lớp đã biết tương tự trong SC

▪ center-based similarity: tương tự theo tâm

⚫ Giải pháp

▪ (1) Tìm SC: Chạy từng bộ phân lớp nhị phân “1-vs-rest” trong FN

với mỗi x DN+1. Lớp “tương tự” với lớp “mới chưa biết” có một

tỷ lệ đoán nhận các x DN+1 vượt qua một ngưỡng cho trước.

▪ (2) gồm hai nội dung: (i) xây dựng phân lớp nhị phân đoán nhận

lớp N+1 với DN+1 tập ví dụ dương và SCDi là tập ví dụ âm (2)

cập nhật các phân lớp thuộc SC với tập ví dụ dương đã biết còn

tập ví dụ âm là tập ví dụ âm đã biết bổ sung thêm DN+1.

100

Thuật toán học gia tăng CBS khái quát

⚫ N

⚫ H

[Fei16] mô tả cụ thể

thuật toán CL-cbsSVM

với “tương tự theo

tâm”

101

Đánh giá thuật toán học gia tăng CBS

⚫ Nhận biết một ví dụ là chưa biết

N+1

▪ Bộ học cập nhật F = {f1, f2, , fN, fN+1}, một thể hiện x, cần xác

định x thuộc một lớp đã biết nào hoặc thuộc một lớp chưa biết.

▪ f1 là các bộ phân lớp nhị phân SVM “1-vs-còn lại” mà điểm đầu

ra SVM khó so sánh

▪ Chuyển điểm đầu ra SVM thành một xác suất P(li|x) theo thuật

toán [Platt99] (có sẵn trong LIBSVM)

⚫ Quyết định

▪ y* : nhãn quyết định cho x

▪ : ngưỡng quyết định, chọn =0.5

▪ Co: “nhãn” lớp mới chưa biết.

102File đính kèm:

bai_giang_khai_pha_du_lieu_ha_quang_thuy.pdf

bai_giang_khai_pha_du_lieu_ha_quang_thuy.pdf