Mô hình ước lượng độ tượng tự giữa các bài viết trên các cổng thông tin giải trí

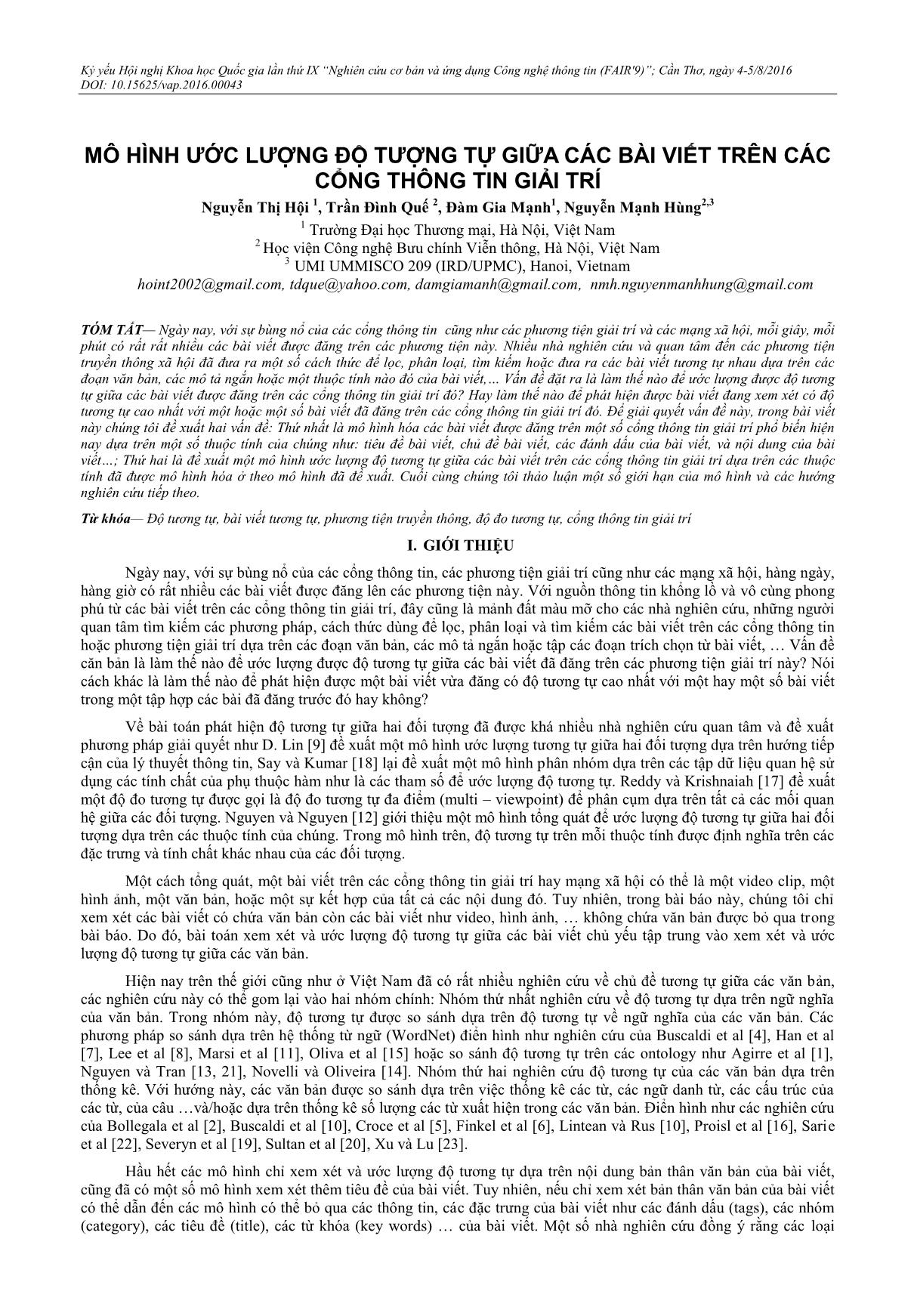

TÓM TẮT— Ngày nay, với sự bùng nổ của các cổng thông tin cũng như các phương tiện giải trí và các mạng xã hội, mỗi giây, mỗi phút có rất rất nhiều các bài viết được đăng trên các phương tiện này. Nhiều nhà nghiên cứu và quan tâm đến các phương tiện truyền thông xã hội đã đưa ra một số cách thức để lọc, phân loại, tìm kiếm hoặc đưa ra các bài viết tương tự nhau dựa trên các đoạn văn bản, các mô tả ngắn hoặc một thuộc tính nào đó của bài viết, Vấn đề đặt ra là làm thế nào để ước lượng được độ tương tự giữa các bài viết được đăng trên các cổng thông tin giải trí đó? Hay làm thế nào để phát hiện được bài viết đang xem xét có độ tương tự cao nhất với một hoặc một số bài viết đã đăng trên các cổng thông tin giải trí đó. Để giải quyết vấn đề này, trong bài viết này chúng tôi đề xuất hai vấn đề: Thứ nhất là mô hình hóa các bài viết được đăng trên một số cổng thông tin giải trí phổ biến hiện nay dựa trên một số thuộc tính của chúng như: tiêu đề bài viết, chủ đề bài viết, các đánh dấu của bài viết, và nội dung của bài viết ; Thứ hai là đề xuất một mô hình ước lượng độ tương tự giữa các bài viết trên các cổng thông tin giải trí dựa trên các thuộc tính đã được mô hình hóa ở theo mô hình đã đề xuất. Cuối cùng chúng tôi thảo luận một số giới hạn của mô hình và các hướng nghiên cứu tiếp theo

Trang 1

Trang 2

Trang 3

Trang 4

Trang 5

Trang 6

Trang 7

Trang 8

Tóm tắt nội dung tài liệu: Mô hình ước lượng độ tượng tự giữa các bài viết trên các cổng thông tin giải trí

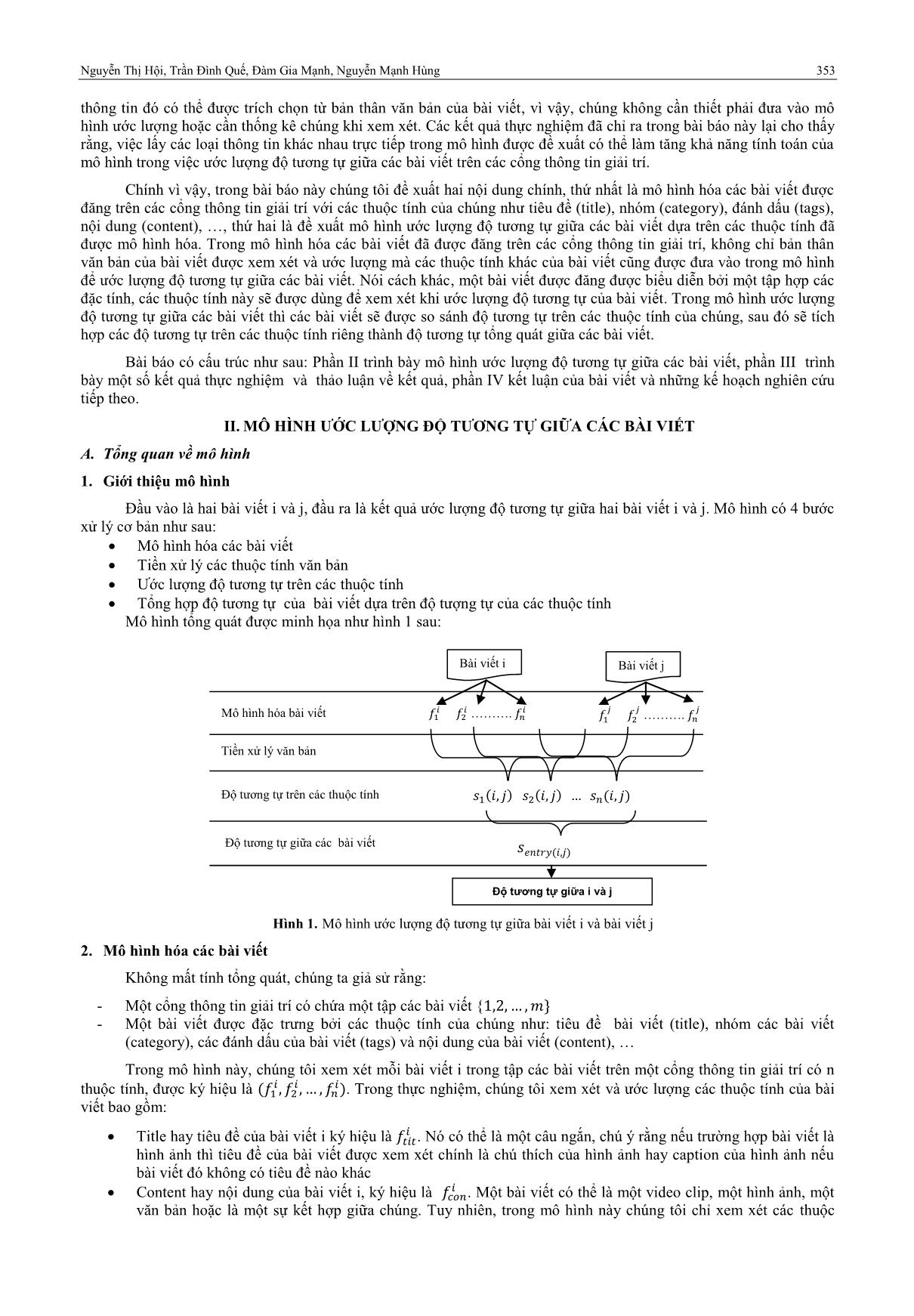

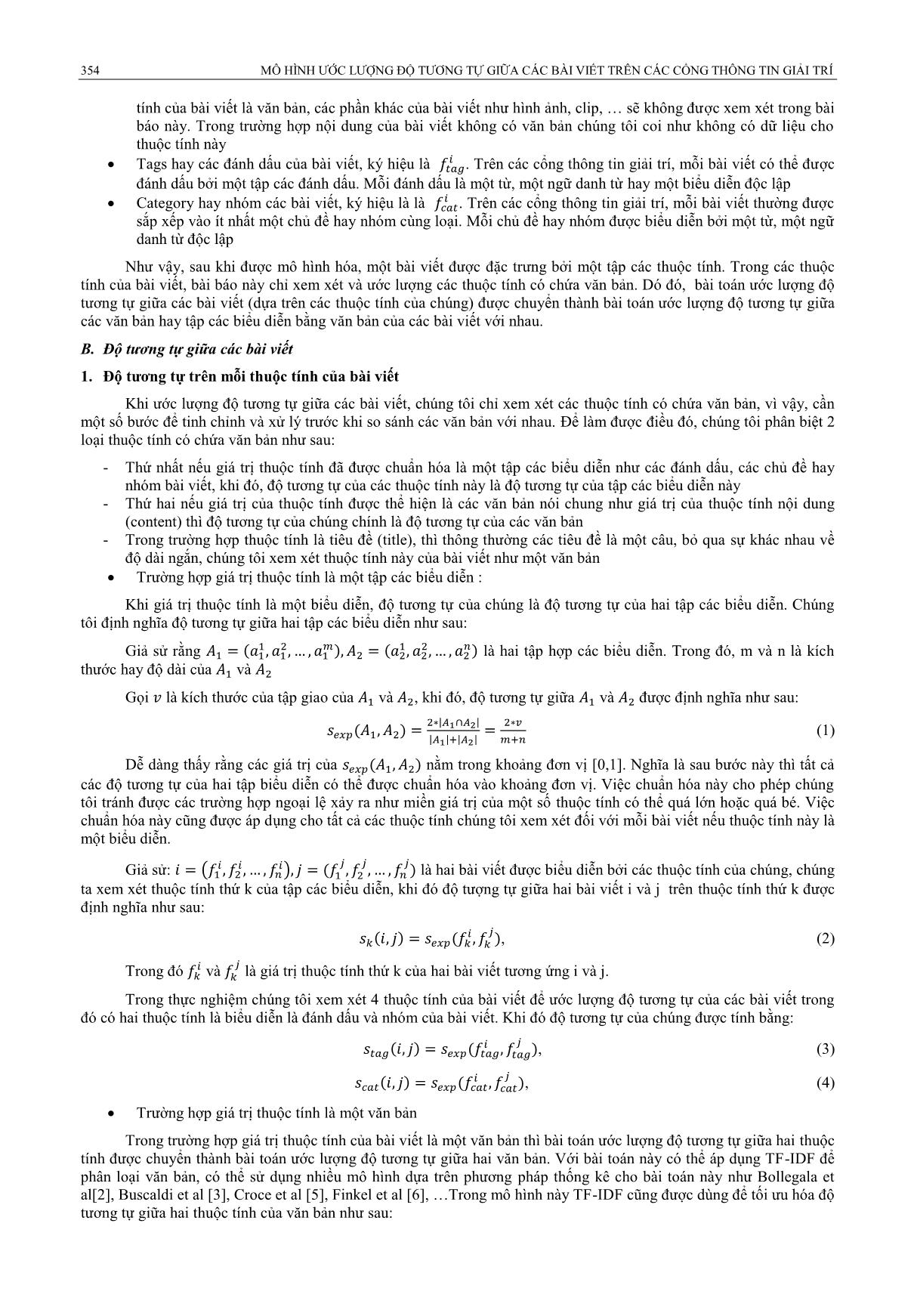

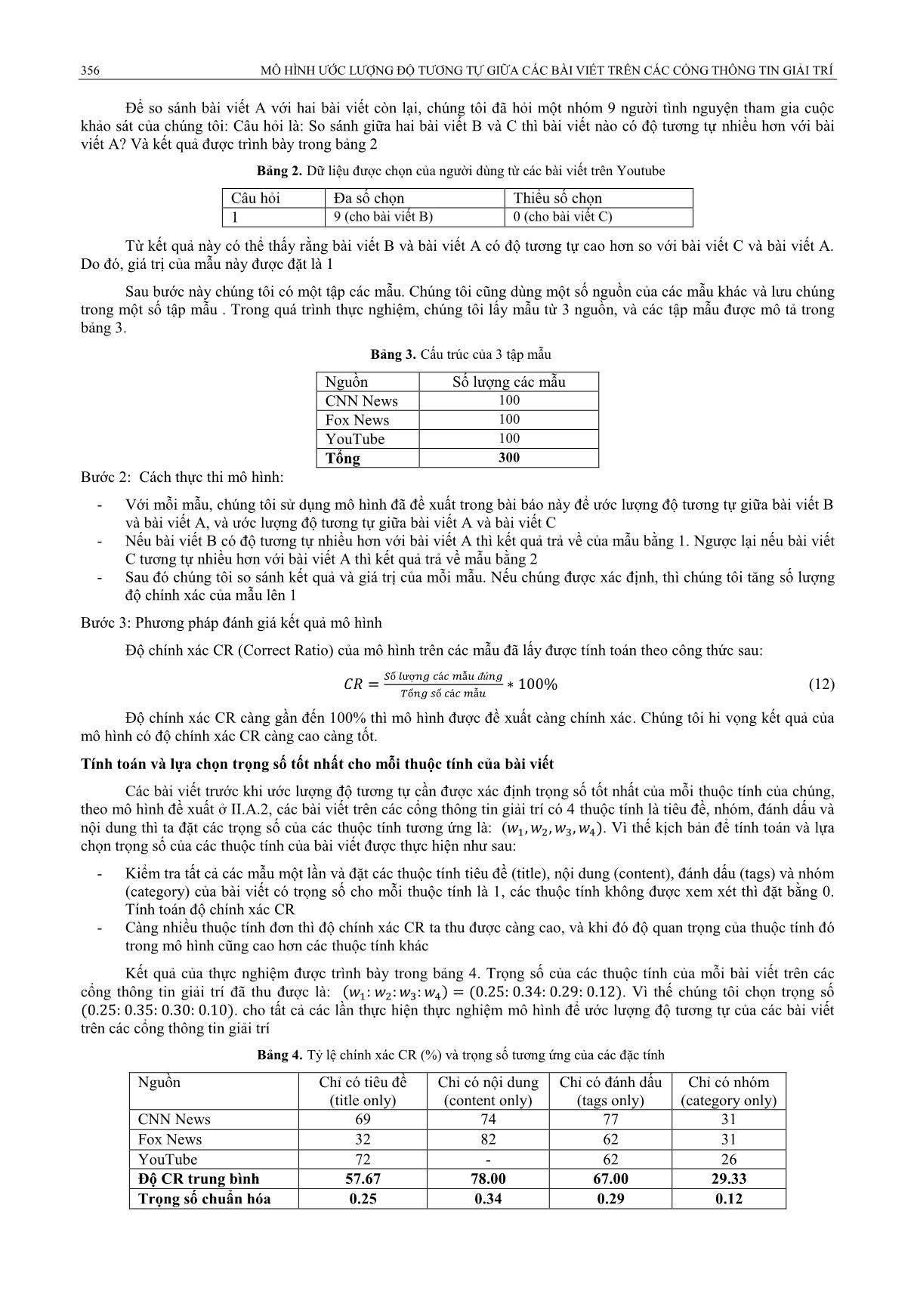

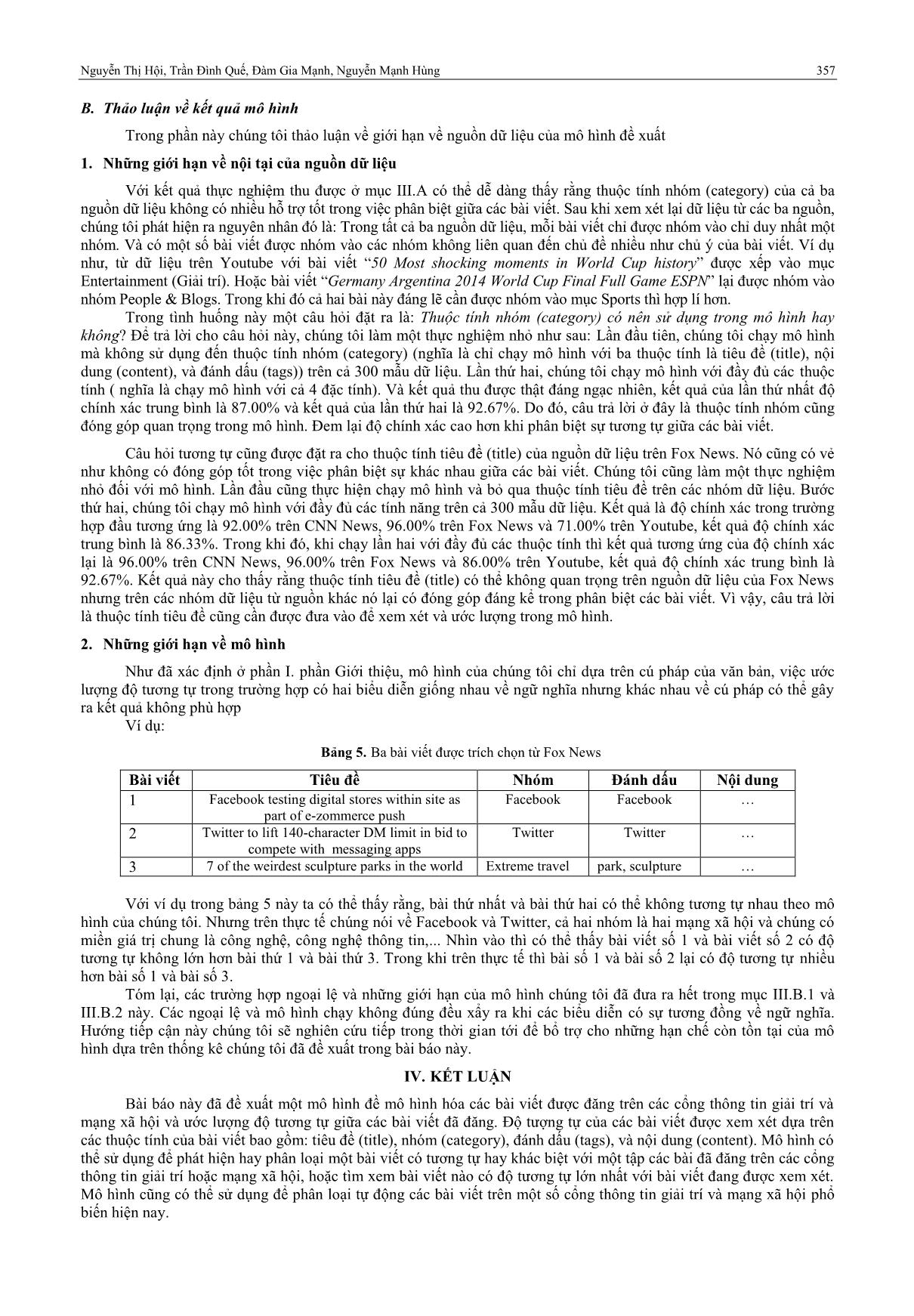

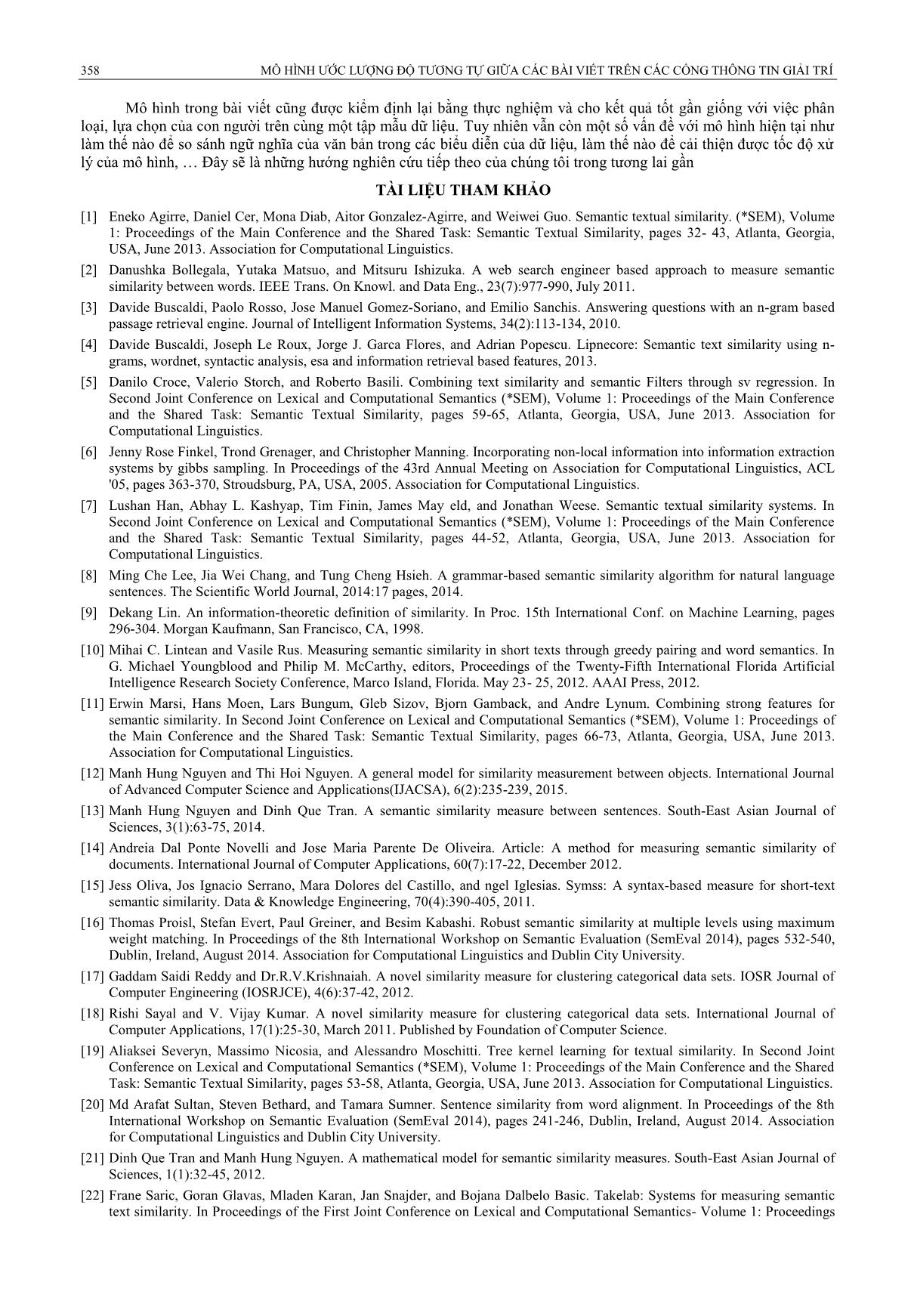

h xác CR càng cao càng tốt. Tính toán và lựa chọn trọng số tốt nhất cho mỗi thuộc tính của bài viết Các bài viết trƣớc khi ƣớc lƣợng độ tƣơng tự cần đƣợc xác định trọng số tốt nhất của mỗi thuộc tính của chúng, theo mô hình đề xuất ở II.A.2, các bài viết trên các cổng thông tin giải trí có 4 thuộc tính là tiêu đề, nhóm, đánh dấu và nội dung thì ta đặt các trọng số của các thuộc tính tƣơng ứng là: ( . Vì thế kịch bản để tính toán và lựa chọn trọng số của các thuộc tính của bài viết đƣợc thực hiện nhƣ sau: - Kiểm tra tất cả các mẫu một lần và đặt các thuộc tính tiêu đề (title), nội dung (content), đánh dấu (tags) và nhóm (category) của bài viết có trọng số cho mỗi thuộc tính là 1, các thuộc tính không đƣợc xem xét thì đặt bằng 0. Tính toán độ chính xác CR - Càng nhiều thuộc tính đơn thì độ chính xác CR ta thu đƣợc càng cao, và khi đó độ quan trọng của thuộc tính đó trong mô hình cũng cao hơn các thuộc tính khác Kết quả của thực nghiệm đƣợc trình bày trong bảng 4. Trọng số của các thuộc tính của mỗi bài viết trên các cổng thông tin giải trí đã thu đƣợc là: . Vì thế chúng tôi chọn trọng số . cho tất cả các lần thực hiện thực nghiệm mô hình để ƣớc lƣợng độ tƣơng tự của các bài viết trên các cổng thông tin giải trí Bảng 4. Tỷ lệ chính xác CR (%) và trọng số tƣơng ứng của các đặc tính Nguồn Chỉ có tiêu đề Chỉ có nội dung Chỉ có đánh dấu Chỉ có nhóm (title only) (content only) (tags only) (category only) CNN News 69 74 77 31 Fox News 32 82 62 31 YouTube 72 - 62 26 Độ CR trung bình 57.67 78.00 67.00 29.33 Trọng số chuẩn hóa 0.25 0.34 0.29 0.12 Nguyễn Thị Hội, Trần Đình Quế, Đàm Gia Mạnh, Nguyễn Mạnh Hùng 357 B. Thảo luận về kết quả mô hình Trong phần này chúng tôi thảo luận về giới hạn về nguồn dữ liệu của mô hình đề xuất 1. Những giới hạn về nội tại của nguồn dữ liệu Với kết quả thực nghiệm thu đƣợc ở mục III.A có thể dễ dàng thấy rằng thuộc tính nhóm (category) của cả ba nguồn dữ liệu không có nhiều hỗ trợ tốt trong việc phân biệt giữa các bài viết. Sau khi xem xét lại dữ liệu từ các ba nguồn, chúng tôi phát hiện ra nguyên nhân đó là: Trong tất cả ba nguồn dữ liệu, mỗi bài viết chỉ đƣợc nhóm vào chỉ duy nhất một nhóm. Và có một số bài viết đƣợc nhóm vào các nhóm không liên quan đến chủ đề nhiều nhƣ chủ ý của bài viết. Ví dụ nhƣ, từ dữ liệu trên Youtube với bài viết ―50 Most shocking moments in World Cup history‖ đƣợc xếp vào mục Entertainment (Giải trí). Hoặc bài viết ―Germany Argentina 2014 World Cup Final Full Game ESPN‖ lại đƣợc nhóm vào nhóm People & Blogs. Trong khi đó cả hai bài này đáng lẽ cần đƣợc nhóm vào mục Sports thì hợp lí hơn. Trong tình huống này một câu hỏi đặt ra là: Thuộc tính nhóm (category) có nên sử dụng trong mô hình hay không? Để trả lời cho câu hỏi này, chúng tôi làm một thực nghiệm nhỏ nhƣ sau: Lần đầu tiên, chúng tôi chạy mô hình mà không sử dụng đến thuộc tính nhóm (category) (nghĩa là chỉ chạy mô hình với ba thuộc tính là tiêu đề (title), nội dung (content), và đánh dấu (tags)) trên cả 300 mẫu dữ liệu. Lần thứ hai, chúng tôi chạy mô hình với đầy đủ các thuộc tính ( nghĩa là chạy mô hình với cả 4 đặc tính). Và kết quả thu đƣợc thật đáng ngạc nhiên, kết quả của lần thứ nhất độ chính xác trung bình là 87.00% và kết quả của lần thứ hai là 92.67%. Do đó, câu trả lời ở đây là thuộc tính nhóm cũng đóng góp quan trọng trong mô hình. Đem lại độ chính xác cao hơn khi phân biệt sự tƣơng tự giữa các bài viết. Câu hỏi tƣơng tự cũng đƣợc đặt ra cho thuộc tính tiêu đề (title) của nguồn dữ liệu trên Fox News. Nó cũng có vẻ nhƣ không có đóng góp tốt trong việc phân biệt sự khác nhau giữa các bài viết. Chúng tôi cũng làm một thực nghiệm nhỏ đối với mô hình. Lần đầu cũng thực hiện chạy mô hình và bỏ qua thuộc tính tiêu đề trên các nhóm dữ liệu. Bƣớc thứ hai, chúng tôi chạy mô hình với đầy đủ các tính năng trên cả 300 mẫu dữ liệu. Kết quả là độ chính xác trong trƣờng hợp đầu tƣơng ứng là 92.00% trên CNN News, 96.00% trên Fox News và 71.00% trên Youtube, kết quả độ chính xác trung bình là 86.33%. Trong khi đó, khi chạy lần hai với đầy đủ các thuộc tính thì kết quả tƣơng ứng của độ chính xác lại là 96.00% trên CNN News, 96.00% trên Fox News và 86.00% trên Youtube, kết quả độ chính xác trung bình là 92.67%. Kết quả này cho thấy rằng thuộc tính tiêu đề (title) có thể không quan trọng trên nguồn dữ liệu của Fox News nhƣng trên các nhóm dữ liệu từ nguồn khác nó lại có đóng góp đáng kể trong phân biệt các bài viết. Vì vậy, câu trả lời là thuộc tính tiêu đề cũng cần đƣợc đƣa vào để xem xét và ƣớc lƣợng trong mô hình. 2. Những giới hạn về mô hình Nhƣ đã xác định ở phần I. phần Giới thiệu, mô hình của chúng tôi chỉ dựa trên cú pháp của văn bản, việc ƣớc lƣợng độ tƣơng tự trong trƣờng hợp có hai biểu diễn giống nhau về ngữ nghĩa nhƣng khác nhau về cú pháp có thể gây ra kết quả không phù hợp Ví dụ: Bảng 5. Ba bài viết đƣợc trích chọn từ Fox News Bài viết Tiêu đề Nhóm Đánh dấu Nội dung 1 Facebook testing digital stores within site as Facebook Facebook part of e-zommerce push 2 Twitter to lift 140-character DM limit in bid to Twitter Twitter compete with messaging apps 3 7 of the weirdest sculpture parks in the world Extreme travel park, sculpture Với ví dụ trong bảng 5 này ta có thể thấy rằng, bài thứ nhất và bài thứ hai có thể không tƣơng tự nhau theo mô hình của chúng tôi. Nhƣng trên thực tế chúng nói về Facebook và Twitter, cả hai nhóm là hai mạng xã hội và chúng có miền giá trị chung là công nghệ, công nghệ thông tin,... Nhìn vào thì có thể thấy bài viết số 1 và bài viết số 2 có độ tƣơng tự không lớn hơn bài thứ 1 và bài thứ 3. Trong khi trên thực tế thì bài số 1 và bài số 2 lại có độ tƣơng tự nhiều hơn bài số 1 và bài số 3. Tóm lại, các trƣờng hợp ngoại lệ và những giới hạn của mô hình chúng tôi đã đƣa ra hết trong mục III.B.1 và III.B.2 này. Các ngoại lệ và mô hình chạy không đúng đều xẩy ra khi các biểu diễn có sự tƣơng đồng về ngữ nghĩa. Hƣớng tiếp cận này chúng tôi sẽ nghiên cứu tiếp trong thời gian tới để bổ trợ cho những hạn chế còn tồn tại của mô hình dựa trên thống kê chúng tôi đã đề xuất trong bài báo này. IV. KẾT LUẬN Bài báo này đã đề xuất một mô hình đề mô hình hóa các bài viết đƣợc đăng trên các cổng thông tin giải trí và mạng xã hội và ƣớc lƣợng độ tƣơng tự giữa các bài viết đã đăng. Độ tƣợng tự của các bài viết đƣợc xem xét dựa trên các thuộc tính của bài viết bao gồm: tiêu đề (title), nhóm (category), đánh dấu (tags), và nội dung (content). Mô hình có thể sử dụng để phát hiện hay phân loại một bài viết có tƣơng tự hay khác biệt với một tập các bài đã đăng trên các cổng thông tin giải trí hoặc mạng xã hội, hoặc tìm xem bài viết nào có độ tƣơng tự lớn nhất với bài viết đang đƣợc xem xét. Mô hình cũng có thể sử dụng để phân loại tự động các bài viết trên một số cổng thông tin giải trí và mạng xã hội phổ biến hiện nay. 358 MÔ HÌNH ƢỚC LƢỢNG ĐỘ TƢƠNG TỰ GIỮA CÁC BÀI VIẾT TRÊN CÁC CỔNG THÔNG TIN GIẢI TRÍ Mô hình trong bài viết cũng đƣợc kiểm định lại bằng thực nghiệm và cho kết quả tốt gần giống với việc phân loại, lựa chọn của con ngƣời trên cùng một tập mẫu dữ liệu. Tuy nhiên vẫn còn một số vấn đề với mô hình hiện tại nhƣ làm thế nào để so sánh ngữ nghĩa của văn bản trong các biểu diễn của dữ liệu, làm thế nào để cải thiện đƣợc tốc độ xử lý của mô hình, Đây sẽ là những hƣớng nghiên cứu tiếp theo của chúng tôi trong tƣơng lai gần TÀI LIỆU THAM KHẢO [1] Eneko Agirre, Daniel Cer, Mona Diab, Aitor Gonzalez-Agirre, and Weiwei Guo. Semantic textual similarity. (*SEM), Volume 1: Proceedings of the Main Conference and the Shared Task: Semantic Textual Similarity, pages 32- 43, Atlanta, Georgia, USA, June 2013. Association for Computational Linguistics. [2] Danushka Bollegala, Yutaka Matsuo, and Mitsuru Ishizuka. A web search engineer based approach to measure semantic similarity between words. IEEE Trans. On Knowl. and Data Eng., 23(7):977-990, July 2011. [3] Davide Buscaldi, Paolo Rosso, Jose Manuel Gomez-Soriano, and Emilio Sanchis. Answering questions with an n-gram based passage retrieval engine. Journal of Intelligent Information Systems, 34(2):113-134, 2010. [4] Davide Buscaldi, Joseph Le Roux, Jorge J. Garca Flores, and Adrian Popescu. Lipnecore: Semantic text similarity using n- grams, wordnet, syntactic analysis, esa and information retrieval based features, 2013. [5] Danilo Croce, Valerio Storch, and Roberto Basili. Combining text similarity and semantic Filters through sv regression. In Second Joint Conference on Lexical and Computational Semantics (*SEM), Volume 1: Proceedings of the Main Conference and the Shared Task: Semantic Textual Similarity, pages 59-65, Atlanta, Georgia, USA, June 2013. Association for Computational Linguistics. [6] Jenny Rose Finkel, Trond Grenager, and Christopher Manning. Incorporating non-local information into information extraction systems by gibbs sampling. In Proceedings of the 43rd Annual Meeting on Association for Computational Linguistics, ACL '05, pages 363-370, Stroudsburg, PA, USA, 2005. Association for Computational Linguistics. [7] Lushan Han, Abhay L. Kashyap, Tim Finin, James May eld, and Jonathan Weese. Semantic textual similarity systems. In Second Joint Conference on Lexical and Computational Semantics (*SEM), Volume 1: Proceedings of the Main Conference and the Shared Task: Semantic Textual Similarity, pages 44-52, Atlanta, Georgia, USA, June 2013. Association for Computational Linguistics. [8] Ming Che Lee, Jia Wei Chang, and Tung Cheng Hsieh. A grammar-based semantic similarity algorithm for natural language sentences. The Scientific World Journal, 2014:17 pages, 2014. [9] Dekang Lin. An information-theoretic definition of similarity. In Proc. 15th International Conf. on Machine Learning, pages 296-304. Morgan Kaufmann, San Francisco, CA, 1998. [10] Mihai C. Lintean and Vasile Rus. Measuring semantic similarity in short texts through greedy pairing and word semantics. In G. Michael Youngblood and Philip M. McCarthy, editors, Proceedings of the Twenty-Fifth International Florida Artificial Intelligence Research Society Conference, Marco Island, Florida. May 23- 25, 2012. AAAI Press, 2012. [11] Erwin Marsi, Hans Moen, Lars Bungum, Gleb Sizov, Bjorn Gamback, and Andre Lynum. Combining strong features for semantic similarity. In Second Joint Conference on Lexical and Computational Semantics (*SEM), Volume 1: Proceedings of the Main Conference and the Shared Task: Semantic Textual Similarity, pages 66-73, Atlanta, Georgia, USA, June 2013. Association for Computational Linguistics. [12] Manh Hung Nguyen and Thi Hoi Nguyen. A general model for similarity measurement between objects. International Journal of Advanced Computer Science and Applications(IJACSA), 6(2):235-239, 2015. [13] Manh Hung Nguyen and Dinh Que Tran. A semantic similarity measure between sentences. South-East Asian Journal of Sciences, 3(1):63-75, 2014. [14] Andreia Dal Ponte Novelli and Jose Maria Parente De Oliveira. Article: A method for measuring semantic similarity of documents. International Journal of Computer Applications, 60(7):17-22, December 2012. [15] Jess Oliva, Jos Ignacio Serrano, Mara Dolores del Castillo, and ngel Iglesias. Symss: A syntax-based measure for short-text semantic similarity. Data & Knowledge Engineering, 70(4):390-405, 2011. [16] Thomas Proisl, Stefan Evert, Paul Greiner, and Besim Kabashi. Robust semantic similarity at multiple levels using maximum weight matching. In Proceedings of the 8th International Workshop on Semantic Evaluation (SemEval 2014), pages 532-540, Dublin, Ireland, August 2014. Association for Computational Linguistics and Dublin City University. [17] Gaddam Saidi Reddy and Dr.R.V.Krishnaiah. A novel similarity measure for clustering categorical data sets. IOSR Journal of Computer Engineering (IOSRJCE), 4(6):37-42, 2012. [18] Rishi Sayal and V. Vijay Kumar. A novel similarity measure for clustering categorical data sets. International Journal of Computer Applications, 17(1):25-30, March 2011. Published by Foundation of Computer Science. [19] Aliaksei Severyn, Massimo Nicosia, and Alessandro Moschitti. Tree kernel learning for textual similarity. In Second Joint Conference on Lexical and Computational Semantics (*SEM), Volume 1: Proceedings of the Main Conference and the Shared Task: Semantic Textual Similarity, pages 53-58, Atlanta, Georgia, USA, June 2013. Association for Computational Linguistics. [20] Md Arafat Sultan, Steven Bethard, and Tamara Sumner. Sentence similarity from word alignment. In Proceedings of the 8th International Workshop on Semantic Evaluation (SemEval 2014), pages 241-246, Dublin, Ireland, August 2014. Association for Computational Linguistics and Dublin City University. [21] Dinh Que Tran and Manh Hung Nguyen. A mathematical model for semantic similarity measures. South-East Asian Journal of Sciences, 1(1):32-45, 2012. [22] Frane Saric, Goran Glavas, Mladen Karan, Jan Snajder, and Bojana Dalbelo Basic. Takelab: Systems for measuring semantic text similarity. In Proceedings of the First Joint Conference on Lexical and Computational Semantics- Volume 1: Proceedings Nguyễn Thị Hội, Trần Đình Quế, Đàm Gia Mạnh, Nguyễn Mạnh Hùng 359 of the Main Conference and the Shared Task, and Volume 2: Proceedings of the Sixth International Workshop on Semantic Evaluation, SemEval '12, pages 441- 448, Stroudsburg, PA, USA, 2012. Association for Computational Linguistics. [23] Jian Xu and Qin Lu. Computing semantic textual similarity using overlapped senses. In Second Joint Conference on Lexical and Computational Semantics (*SEM), Volume 1: Proceedings of the Main Conference and the Shared Task: Semantic Textual Similarity, pages 90-95, Atlanta, Georgia, USA, June 2013. Association for Computational Linguistics. MULTI FEATURES-BASED SIMILARITY AMONG ENTRIES ON MEDIA PORTALS Thi Hoi Nguyen, Dinh Que Tran, Gia Manh Dam, and Manh Hung Nguyen ABSTRACT— Nowadays, with the exploration of entertainment, news or media portals and the social networks, there is a huge number of entries posted on these portals. This raises several issues to filter, classify, and/or search for entries which are similar to a given text, a short description, or a selected entry, etc. The core basic problem of these issues is how to measure the similarity among the entries posted on the mentioned portals: with a given entry, and a set of entries to consider, how to detect the entry in the considered set which is the most similar to the given entry. This paper firstly models the entries on posted on media or entertainment portals based on their features such as title, category, tags, and content, etc. And secondly it presents a model for estimating the similarity among these entries.

File đính kèm:

mo_hinh_uoc_luong_do_tuong_tu_giua_cac_bai_viet_tren_cac_con.pdf

mo_hinh_uoc_luong_do_tuong_tu_giua_cac_bai_viet_tren_cac_con.pdf